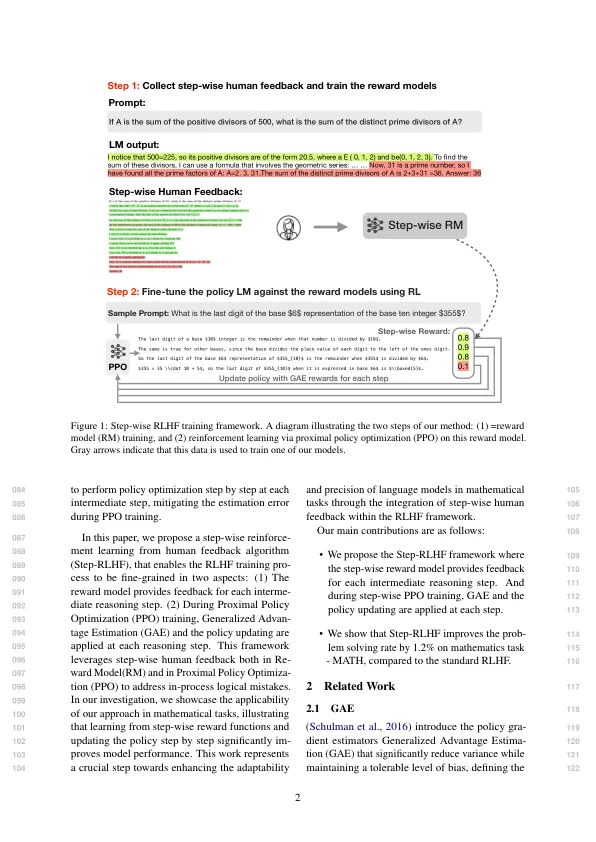

语言模型的训练过程具有Demon-043在减少虚假,有毒和其他044不想要的模型生成输出方面具有潜在的潜力。但是,Cur- 045租金RLHF(Ramamurthy等人,2023; Bai等。,046 2022a,b)始终依靠整体反馈,047在识别具有长文本输出049(例如数学)的048多步推理任务中识别特定错误的局限性。050最近,细粒度RLHF(Wu等人,051 2023)提议提供细粒的进料-052回到LMS输出,将UN-053类别的类别相关联(例如,false或false或无关的属 - 054个tions)和一个密度的文本跨度(例如,句子或055 subs-sendence sendence sendence sendence leellevel)。他们将多个精细奖励奖励整合到近端政策优化057(PPO)中(Schulman等人。,2017年)用于训练LMS 058,具有基于偏好的人类反馈,该反馈概念显示了疗效和数据效率060(具有密集奖励的培训模型的培训效率)比较了061与两个LAN-LAN-062 Gaige Instrice separtions的整体序列奖励奖励(GEHMAN 063 ET。,2020年)和长期问题回答064(QA)(Stelmakh等人,2022)。另一项紧密的重新统计工作,程序监督奖励模型066(PRM)(Lightman等人,2023),使用过程067监督培训为每个068中间推理步骤提供反馈,表明过程069监督比结果监督更可靠的奖励070型号。RE-074病房模型能够提供句子级别或075步骤级奖励。071尽管有这些优势,但仅限072才证明了收集人类反馈和073培训的方式是更可靠的奖励模型。虽然在近端策略076优化(PPO)培训期间,策略模型为077仍针对样本级别的奖励进行了优化,每个示例的策略更新为078。PPO培训中的广义AD-079 Vantage估计函数(GAE)080导致偏差,尤其是对于需要081生成长形式文本的任务,例如复杂的082数学任务。因此,它也很重要083

从人类反馈

主要关键词