机构名称:

¥ 1.0

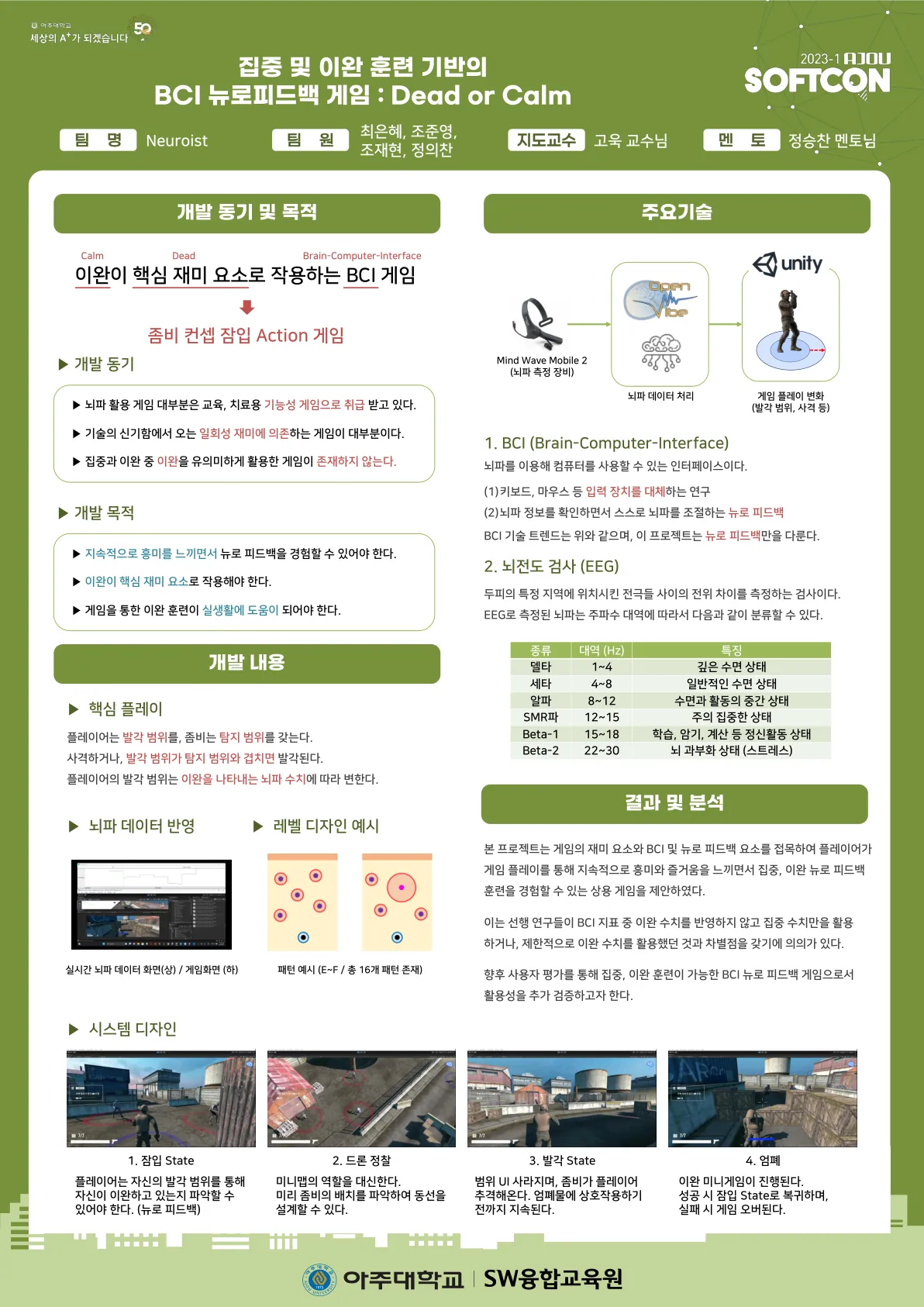

我们考虑深度强化学习 (DRL) 领域的以下核心问题:如何使用隐式人类反馈来加速和优化 DRL 算法的训练?最先进的方法依赖于任何明确提供的人为反馈,需要人类的主动参与(例如,专家标记、演示等)。在这项工作中,我们研究了一种替代范式,其中非专家人类正在默默观察(和评估)与环境交互的代理。通过将电极放在人的头皮上并监测所谓的事件相关电位,人类对代理行为的内在反应被感知为隐式反馈。然后使用隐式反馈来增强代理在 RL 任务中的学习。我们开发了一个系统来获取并准确解码隐式人类反馈,特别是 Atari 类型环境中的状态-动作对的错误相关事件电位 (ErrP)。作为一项基线贡献,我们证明了使用脑电图 (EEG) 帽捕获人类观察者观察代理学习玩几种不同 Atari 游戏的错误潜力的可行性,然后适当地解码信号并将其用作 DRL 算法的辅助奖励函数,旨在加速其对游戏的学习。在此基础上,我们在工作中做出了以下新颖的贡献:(i)我们认为 ErrP 的定义可以在不同的环境中推广;具体来说,我们表明观察者的 ErrP 可以针对特定游戏进行学习,并且该定义可以按原样用于另一个游戏,而无需重新学习错误潜力。(ii)为了提高 ErrP 数据效率,我们提出了一个新的学习框架,将 DRL 的最新进展结合到基于 ErrP 的反馈系统中,允许人类仅在 RL 代理训练开始之前提供隐式反馈。 (iii)最后,我们将基于隐式人类反馈(通过 ErrP)的 RL 扩展到相当复杂的环境(游戏),并通过合成和真实用户实验证明了我们的方法的重要性。

利用隐式人类反馈玩游戏

主要关键词