机构名称:

¥ 1.0

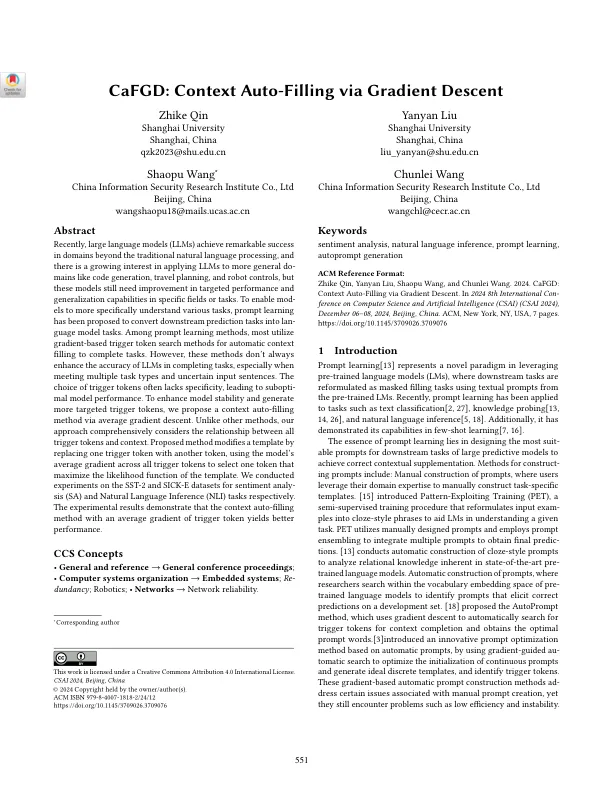

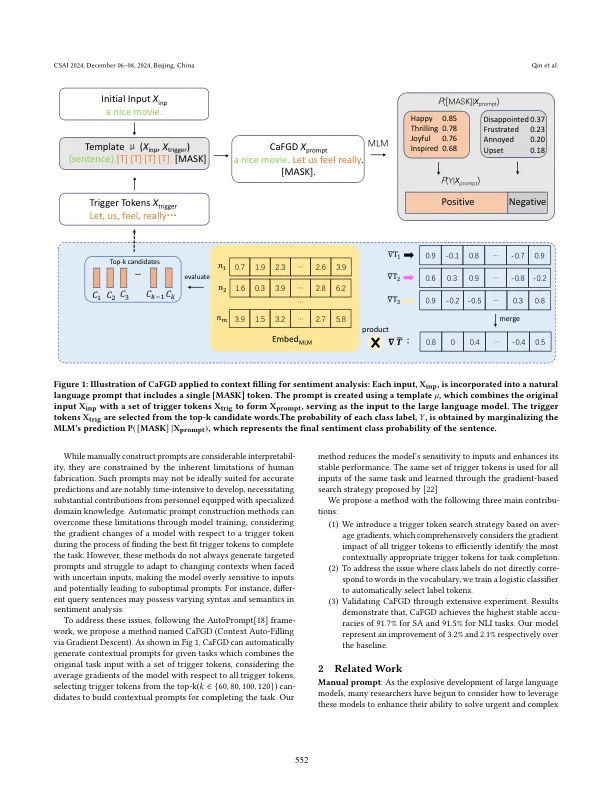

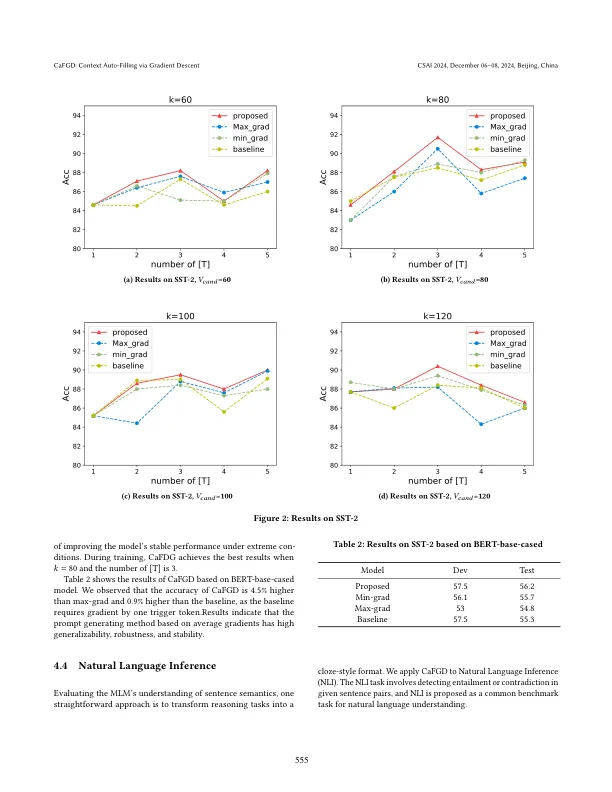

最近,大型语言模型(LLMS)在传统的自然语言处理以外的领域取得了显着的成功,并且越来越有兴趣将LLMS应用于诸如代码生成,旅行计划和机器人控制之类的更一般性,但是这些模型仍然需要提高针对性的性能和特定领域或任务的概括能力。为了使Mod-Els更具体地了解各种任务,已提出提示学习将下游预测任务转换为语言模型任务。在提示学习方法中,大多数利用基于梯度的触发令牌搜索方法来自动上下文填充来完成任务。但是,这些方法并不总是提高LLM在完成任务时的准确性,尤其是在满足多种任务类型和不确定的输入句子时。触发令牌的选择通常缺乏特异性,从而导致模型性能。为了增强模型稳定性并生成更具针对性的触发令牌,我们通过平均梯度下降提出了上下文自动填充方法。与其他方法不同,我们的方法全面考虑了所有触发令牌与上下文之间的关系。提出的方法通过使用模型在所有触发令牌上的平均梯度选择一个令牌来选择一个令牌,从而选择一个令牌,从而选择一个令牌,从而选择一个令牌,从而选择一个令牌,从而选择了一个令牌,从而选择了一个令牌,从而选择了一个令牌,从而选择一个令牌来选择一个令牌,从而选择一个令牌,从而选择一个令牌,从而最大程度地利用模板的可能性函数来选择一个令牌。我们分别在SST-2和SICE-E数据集上进行了实验,分别进行了情感分析(SA)和自然语言推断(NLI)任务。实验结果表明,具有平均触发令牌梯度的上下文自动填充方法可产生更好的性能。

cafgd:通过梯度下降自动填充上下文

主要关键词