机构名称:

¥ 1.0

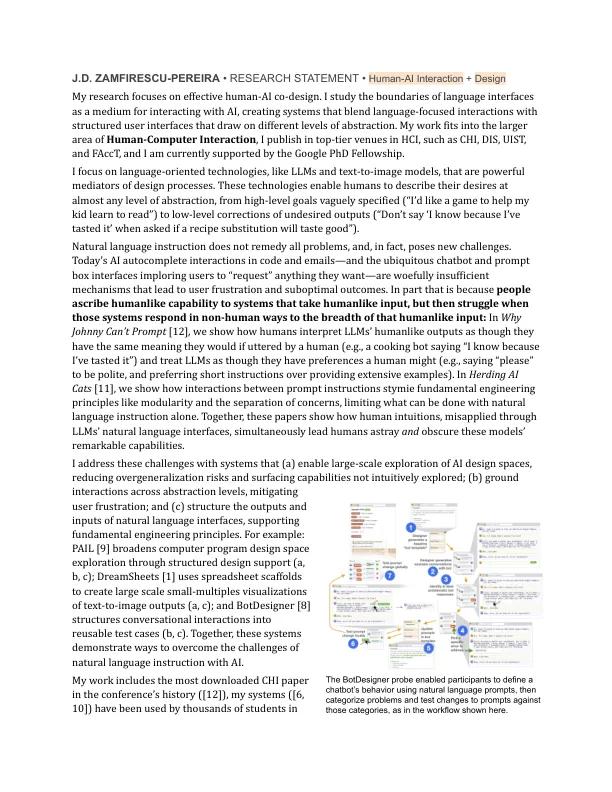

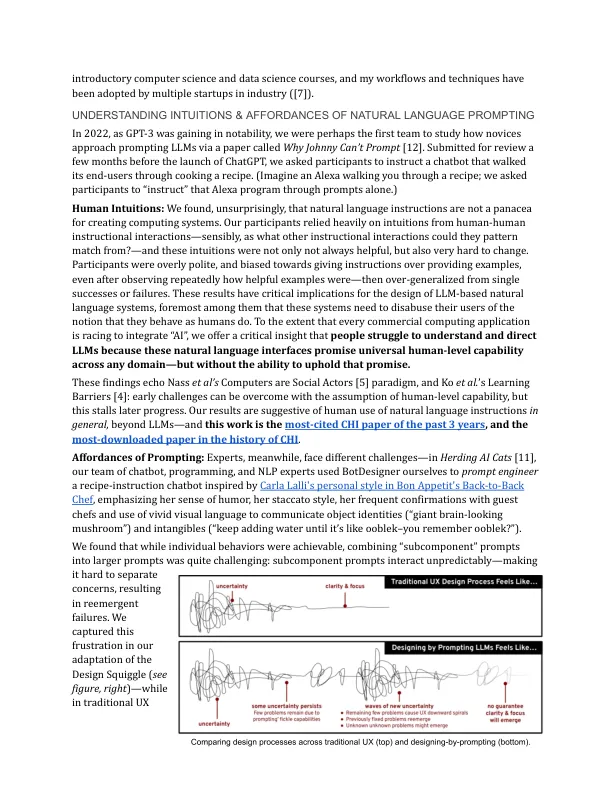

自然语言指令并不能解决所有问题,实际上会带来新的挑战。当今的AI在代码和电子邮件中进行了自动完整的互动,以及无处不在的聊天机器人和迅速的盒子互动,恳请用户“请求”他们想要的任何东西 - 非常不足以使用户沮丧和近距离观察到任何机制。In part that is because people ascribe humanlike capability to systems that take humanlike input, but then struggle when those systems respond in non-human ways to the breadth of that humanlike input: In Why Johnny Can't Prompt [12] , we show how humans interpretLLMs' humanlike outputs as though they have the same meaning they would if uttered by a human (e.g., a cooking bot saying “I know because I've tasted it”) and treat LLMs as though they拥有人类的偏好(例如,说“请”有礼貌,而不是简短的说明而不是提供广泛的例子)。在放牧AI猫[11]中,我们展示了如何在模块化和关注点等方面的基本工程原则之间的互动,仅使用自然语言指导就可以做些什么。一起,这些论文展示了人类直觉是如何通过LLMS的自然语言界面误用的,同时使人类误入歧途,并掩盖了这些模型的显着能力。

研究声明•人类互动 +设计

主要关键词