机构名称:

¥ 1.0

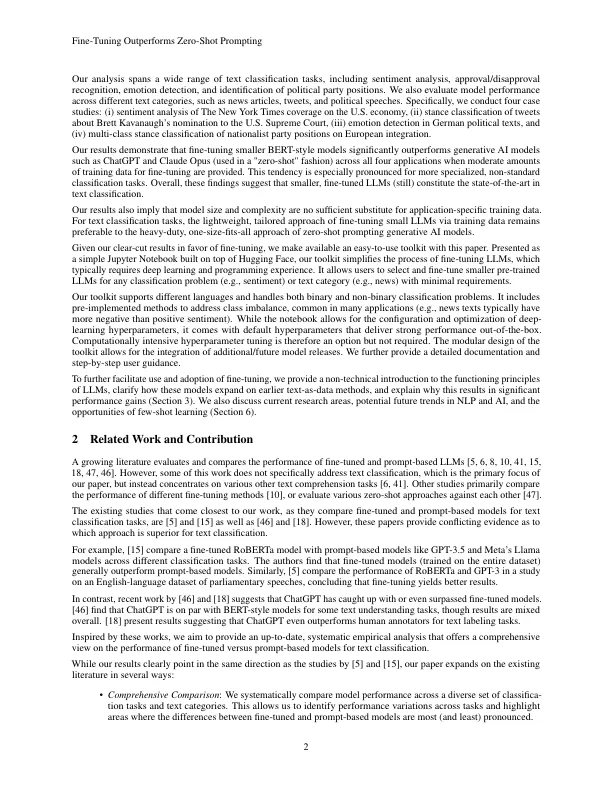

生成AI提供了一种简单的,基于及时的替代方案,用于微调较小的BERT风格的LLM,以进行文本分类任务。这有望消除对手动标记的培训数据和特定于任务模型培训的需求。但是,仍然是一个悬而未决的问题。在本文中,我们表明,较小的,微调的LLM(仍然)始终如一,明显优于较大的零射击,这促使文本分类中的模型。我们将三种主要的生成AI模型(与GPT-3.5/GPT-4和Claude Opus)与多种分类任务(情感,批准/不赞成,情绪,情感,党派职位)和文本类别(新闻,推文,演讲,演讲)中进行了比较。我们发现,在所有情况下,使用特定于应用程序的培训数据进行微调均可取得卓越的性能。为了使更广泛的受众更容易访问这种方法,我们将提供一个易于使用的工具包。我们的工具包,伴随着非技术分步指导,使用户能够以最小的技术和计算工作来选择和调整类似BERT的LLM,以完成任何分类任务。

微调的“小” llm(仍然)明显优于零射击...

主要关键词