机构名称:

¥ 1.0

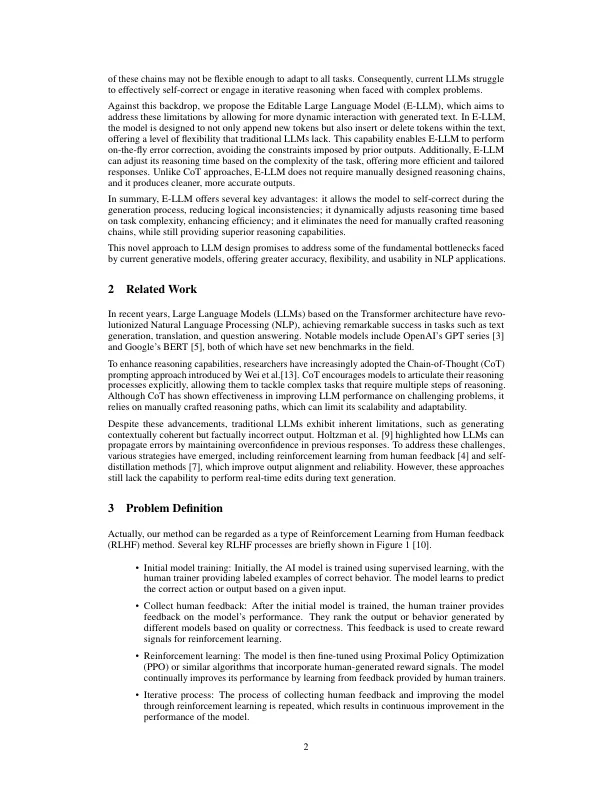

我们创新了一个可编辑的llm,可以像人类的反思过程一样,可以不断地实时反映和修改生成的内容。更确切地说,我们根据传统的生成大型模型添加了检查机制,该模型实现了添加,删除,纠正和检查生成的文本的操作。在模拟修改完成后,文本质量分数提供的监督信号就像从人类反馈(RLHF)学习一样。然而,与传统的RLHF研究不同,我们的重点不是从多个输出中选择最佳,而是指导LLM逐步改善大草稿,逐步改善高质量的输出,这更像是人类反思的过程,而更多地符合加强学习的过程。更具体地说,我们不是手动注释,而是在粗制模型上生成草稿,但是指导更改模型的更改。我们的方法在真实数据上取得了很好的结果,该数据发现了LLM研究的新研究方向,尤其是在RLHF领域。

像人类一样自我反思,可编辑-llm(e- ...