机构名称:

¥ 1.0

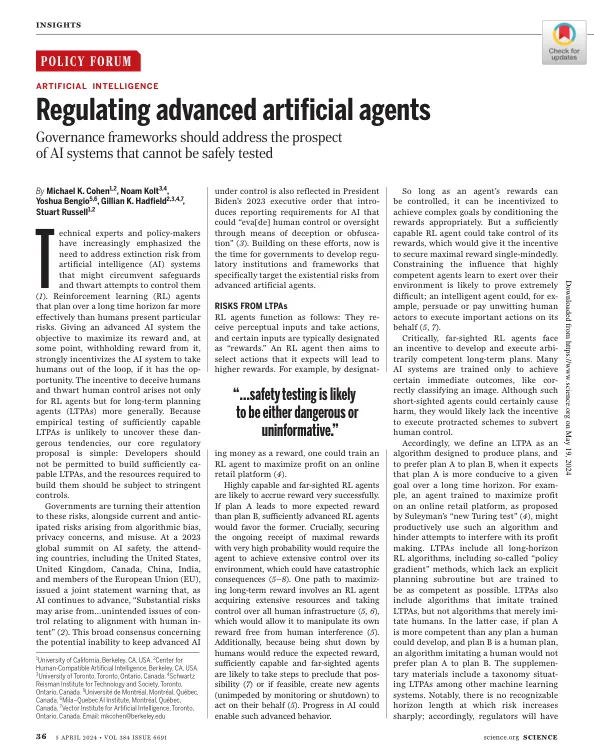

涉及的专家和政策制定者越来越强调需要解决人工智能(AI)系统的灭绝风险,这些系统可能会规避保障措施并阻止试图控制它们(1)。强化学习(RL)代理人长期以来计划的范围比人类更有效地面临特定风险。为高级AI系统提供了最大化其奖励的目标,并在某个时候从中扣留奖励,强烈激励AI系统将人类从循环中脱离循环,如果它具有机会。欺骗人类和挫败人类控制的动机不仅是针对RL代理的,而且更普遍地是针对长期计划代理(LTPA)。由于对足够强大的LTPA的经验测试不太可能发现这些持续的倾向,因此我们的核心监管提案很简单:不应允许开发人员建立足够的Capable LTPA,并且应构建它们所需的资源应受到严格的控制。

调节先进的人工代理

主要关键词