机构名称:

¥ 2.0

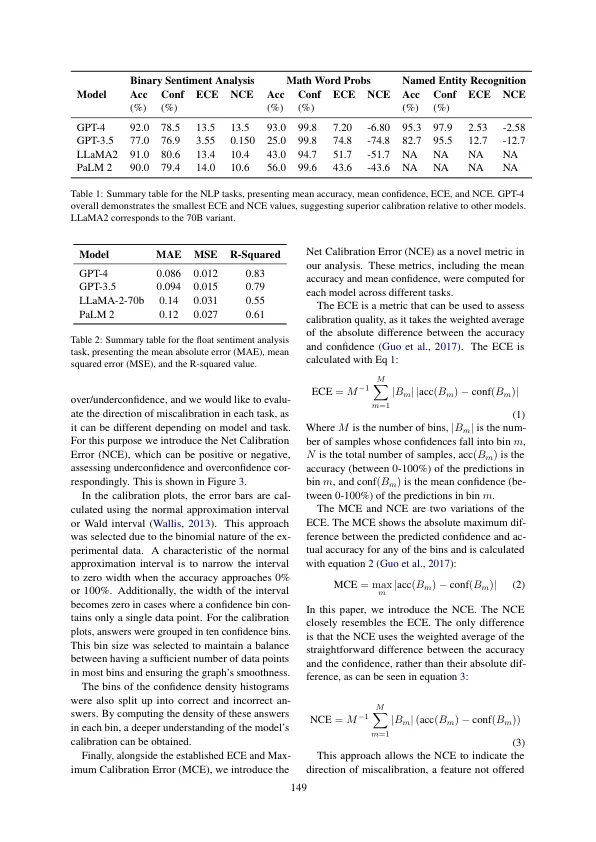

语言和视觉模型(LLMS/VLMS)通过产生类似人类的文本和理解图像的能力彻底改变了AI领域,但是确保其可靠性至关重要。本文旨在评估LLM(GPT4,GPT-3.5,Llama2和Palm 2)和VLMS(GPT4V和Gemini Pro Vision)通过提示估算其口头上的不确定性的能力。我们提出了新的日本不确定场景(JUS)数据集,旨在通过困难的查询和对象计数测试VLM功能,以及净校准误差(NCE)来测量错误校准的方向。结果表明,LLMS和VLM都有很高的校准误差,并且大多数时候都过高地表明不确定性估计的能力较差。此外,我们为回归任务开发了提示,并且我们表明,在产生平均/标准偏差和95%置信区间时,VLM的校准较差。

过度自信是关键:大语言和视觉语言模型的口头不确定性评估