机构名称:

¥ 1.0

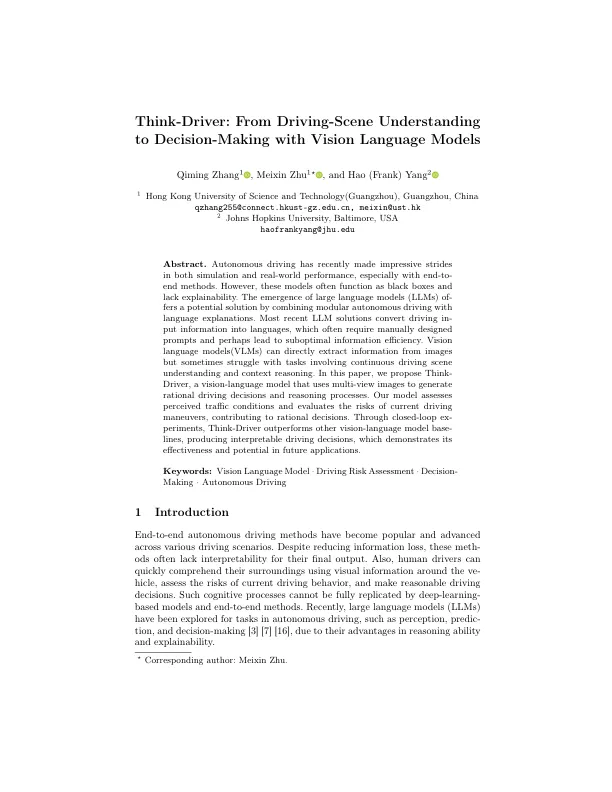

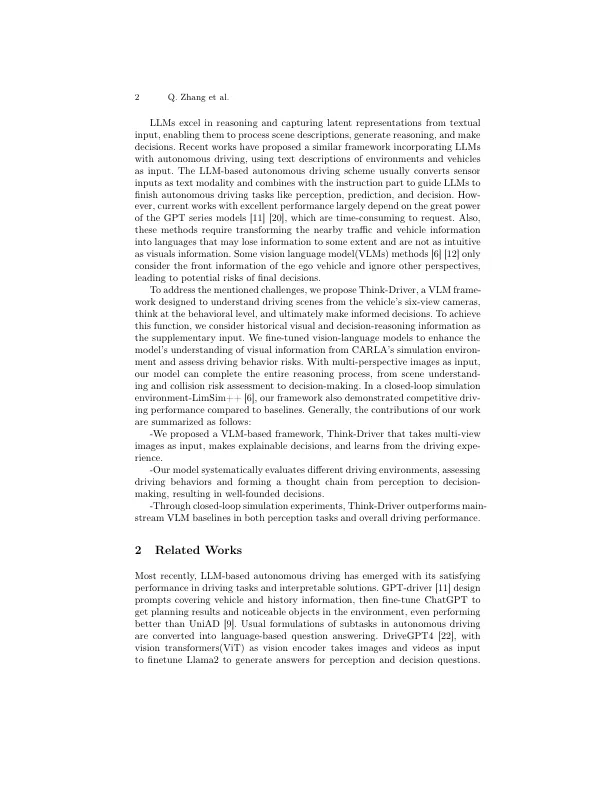

摘要。自主驾驶最近在模拟和现实世界中都取得了令人印象深刻的进步,尤其是端到端方法。但是,这些模型通常充当黑匣子,并且缺乏解释性。大型语言模型(LLM)的出现通过将模块化自主驾驶与语言解释相结合,从而解决了潜在的解决方案。最新的LLM解决方案将驱动信息转换为语言,这些语言通常需要手动设计的提示,并可能导致次优信息效率。视觉语言模型(VLM)可以直接从图像中提取信息,但有时会在涉及持续驾驶场景理解和上下文推理的任务中挣扎。在本文中,我们提出了Think-Driver,这是一种视觉语言模型,该模型使用多视图图像来生成合理的驾驶决策和推理过程。我们的模型评估了感知到的交通状况,并评估当前驾驶操作的风险,从而有助于理性决策。通过闭环的话题,思想驱动器的表现优于其他视觉模型基础线,从而产生了可解释的驾驶决策,从而证明了其在未来应用中的有效性和潜力。

思维驱动器:从驾驶现场理解到视觉语言模型的决策