机构名称:

¥ 1.0

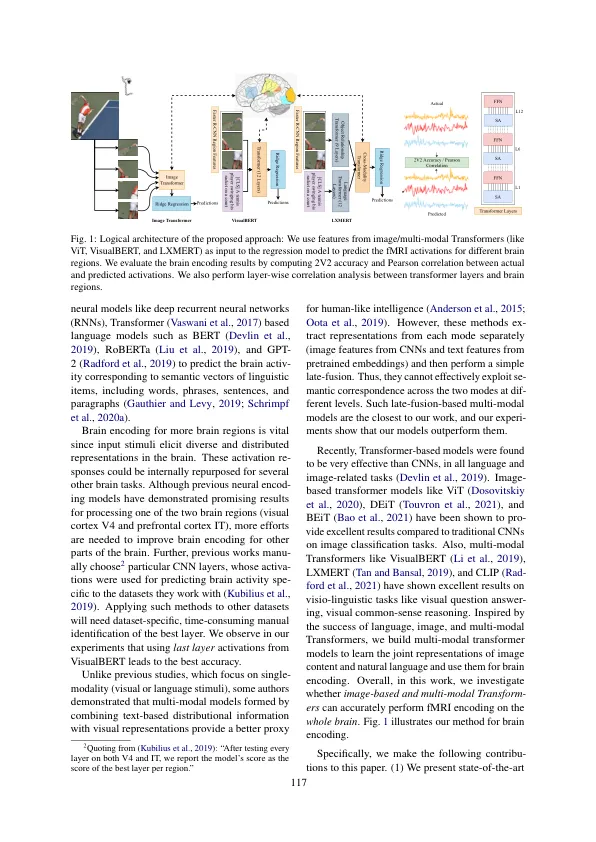

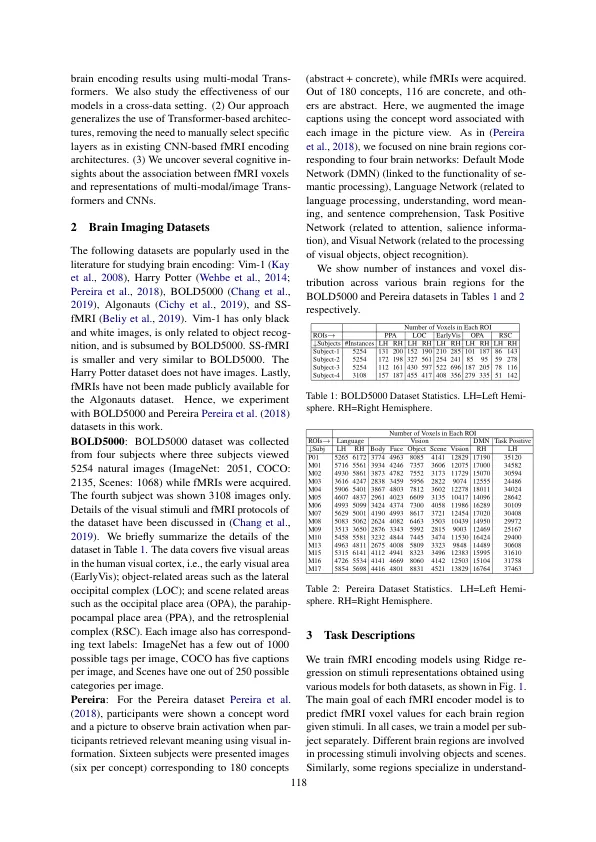

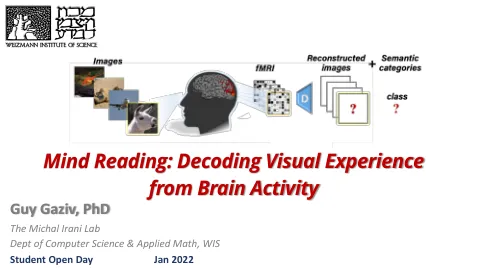

脑编码旨在重建受到刺激时的 fMRI 脑活动。早期的神经编码模型侧重于单模式刺激的脑编码:视觉(预训练的 CNN)或文本(预训练的语言模型)。最近很少有论文获得单独的视觉和文本表示模型,并使用简单的启发式方法进行后期融合。然而,人类大脑使用来自多种模态的信息来感知环境,以前的研究还没有探索用于视觉和文本推理的共同注意多模态编码。本文系统地探讨了图像和多模态 Transformers 对脑编码的功效。在两个流行数据集 BOLD5000 和 Pereira 上进行的大量实验提供了以下见解。 (1) 我们发现,多模态 Transformer VisualBERT 的表现明显优于之前提出的单模态 CNN、图像 Transformer 以及其他之前提出的多模态模型,从而确立了新的最高水平。 (2) LPTG、LMTG、LIFG 和 STS 等具有语言和视觉双重功能的区域与多模态模型的相关性更高,这进一步证明了这些模型擅长模仿人类大脑行为。 (3) 视觉语言模型的优越性引发了一个问题:即使在被动观看图像时,视觉区域引起的反应是否也会受到语言处理的隐性影响。未来的 fMRI 任务可以在适当的实验环境中验证这一计算洞察。我们的代码已公开发布 1 。

视觉语言大脑编码

主要关键词