机构名称:

¥ 1.0

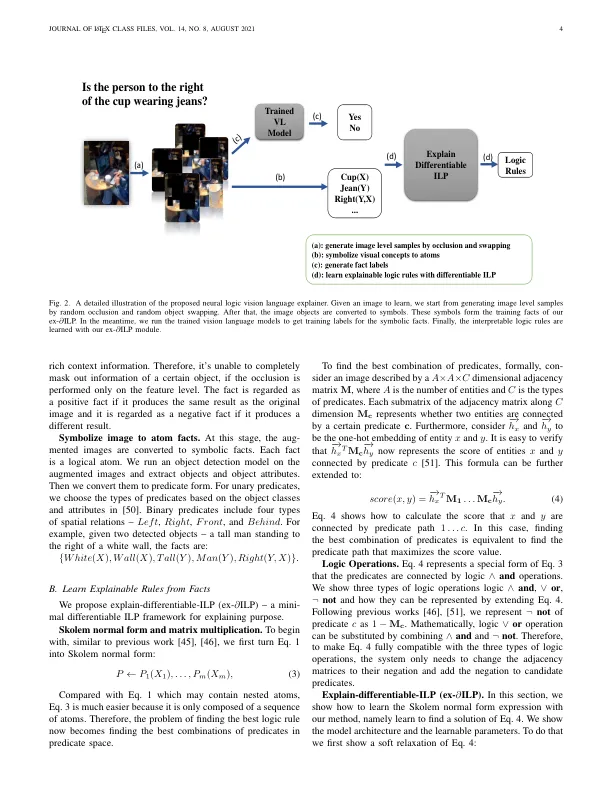

摘要 - 如果我们比较了人类的理由和模型的深入原因,那么人类以象征性的方式与称为逻辑的正式语言进行理性,而大多数深层模型中的理由是黑框。一个自然的问题是“受过训练的深层模型是否与人类相似?”还是“我们可以用逻辑语言解释深层模型的推理吗?” 。在这项工作中,我们提出了Neurlogx,以解释逻辑语言中深视觉语言模型的推理过程。给定训练有素的视觉语言模型,我们的方法首先通过增加输入数据来生成推理事实。然后,我们开发一个可区分的归纳逻辑编程框架,以从事实中学习可解释的逻辑规则。我们在各种流行的视觉语言模型上显示了我们的结果。有趣的是,我们观察到几乎所有经过测试的模型都可以从逻辑上推理。

神经逻辑视觉语言解释器-Dr -ntu