机构名称:

¥ 1.0

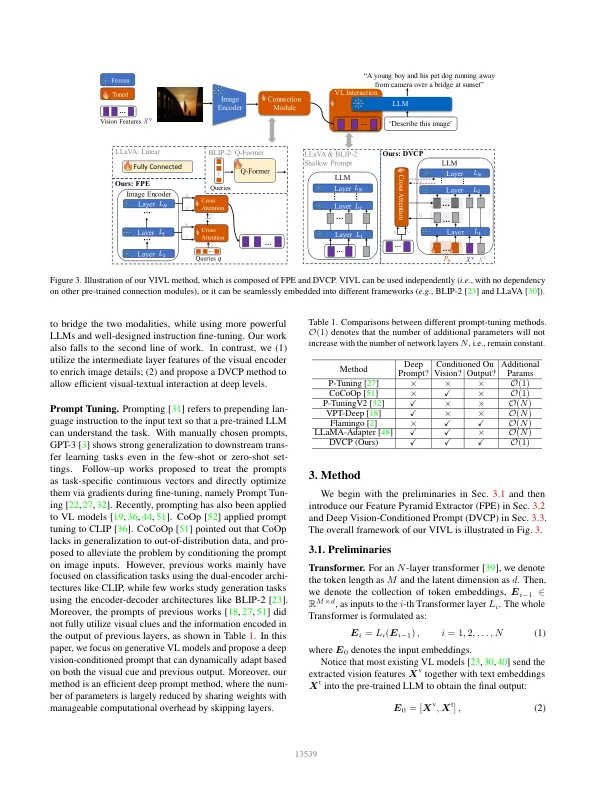

视觉语言(VL)模型最近取得了未经证实的成功,其中连接模块是弥合模式差距的关键。尽管如此,在大多数存在方法中,富裕的视觉线索尚未充分利用。在视觉侧,大多数现有方法仅使用视觉塔的最后一个功能,而无需使用低级功能。在语言方面,大多数现有的方法仅引入浅视力互动。在本文中,我们提出了一个视觉启发的视觉语言连接模块,称为VIVL,该模块有效利用了VL模型的视觉提示。为了利用视觉塔中的较低级别信息,引入了特征金字塔提取器(FPE),以结合不同中间层的特征,该特征将视觉提示与可忽略不计的参数和计算在头顶上。为了实现VL相互作用,我们提出了深视觉条件的提示(DVCP),可以有效地进行视觉和语言特征的深层互动。我们的VIVL超过了以前的最新方法,当时是18.1苹果酒在从头开始训练可可字幕任务,这极大地提高了数据效率。当用作插件模块时,VIVL始终提高各种骨干和VL框架的性能,在多个基准测试中提供新的最新结果,例如Nocaps和VQAV2。

朝着更好的视力启发的视觉语言模型

主要关键词