机构名称:

¥ 1.0

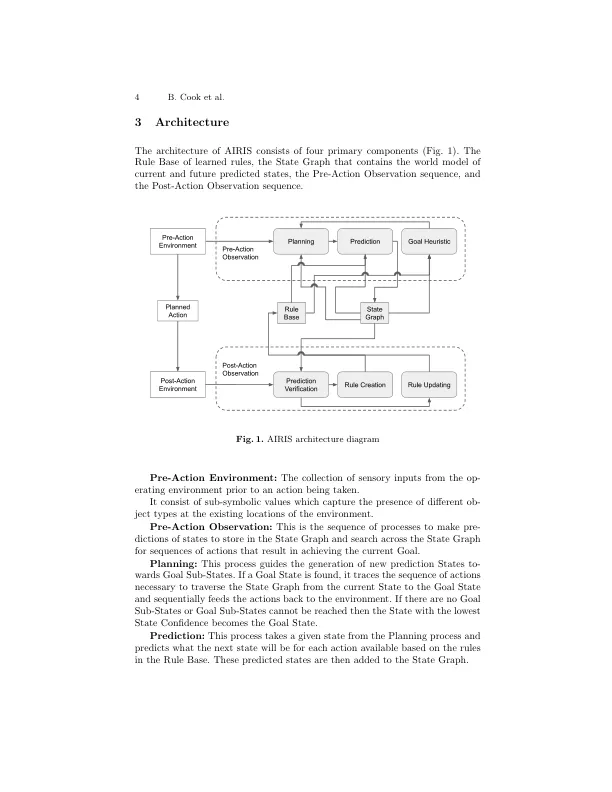

使用专家系统[3],可以编码可以代表环境或应用程序域中固有的因果规则的简单规则集。这些规则控制系统(或系统的代理)如何感知环境,计划行动并执行任务。规则是由决定系统行为的人类程序员手工编码的。在视频游戏等环境中,这些规则可能会导致能够与环境,其他代理和玩家进行复杂的互动的智能代理。不幸的是,这些规则在程序员提供的规则之外的情况之外时,这些规则很容易失败。airis是一种从对其操作环境的原始观察结果中自主学习专家的休闲规则的方法。每个规则都描述了状态的部分变化(而不是全州过渡),并且可以共同用于通过将规则预先确定不匹配的投票机制产生未来的预测状态。在高水平上,这导致了代表内部世界模型的动作状态图。但是,与马尔可夫决策过程(MDP,[8])中的状态转移模型相比,代理可以构建代理商以前尚未经历过的未来状态。Sys-TEM然后使用该世界模型上的任何计划算法来制定计划和执行任务,同时使其具有与非平稳环境的灵活性,并通过典型的MDP形式化可以实现强化学习推动者[5]超越强化学习剂[5]来实现的灵活性。airis保留了透明度,可变性,可忽视性和有效性等专家系统的所有好处,同时还提供了灵活性和

自主智能强化推断象征主义

主要关键词