机构名称:

¥ 1.0

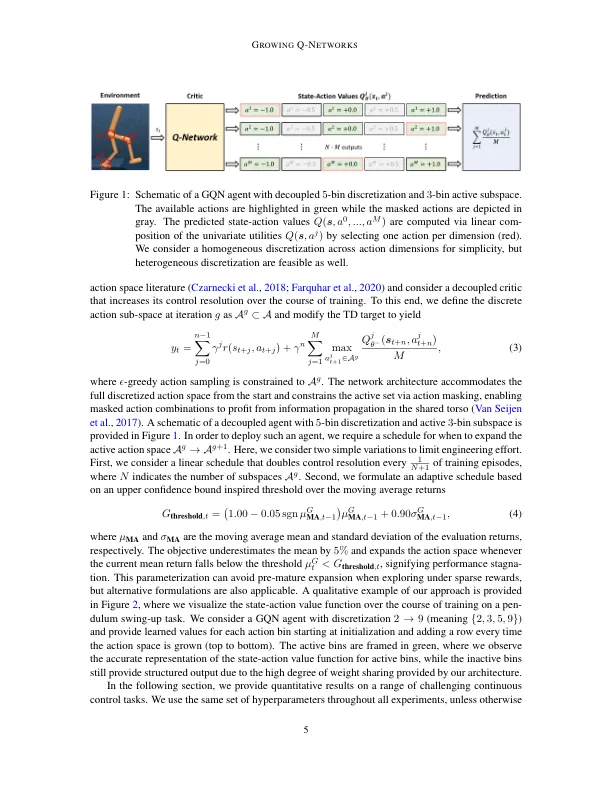

最近的强化学习方法表明,爆炸性政策的强大能力可解决连续控制基准。潜在的粗糙动作空间离散通常会产生有利的探索特征,而在与最佳控制理论一致的情况下,最终绩效并不明显地遭受损失。在机器人技术应用中,平滑控制信号通常是降低系统磨损并提高能源效率的首选,而通过行动成本正规化可能会损害探索。我们的工作旨在通过将离散的动作空间从粗糙控制到精细的控制分辨率来弥合这一绩效差距。我们利用脱钩Q学习的最新结果来扩展我们对高维作用空间的方法,直至DIM(A)= 38。我们的工作表明,自适应控制与价值分解相结合产生了简单的仅批评算法,这使得能够在连续的控制任务上具有出乎意料的强劲性能。关键字:连续控制; Q学习;价值分解;增长分辨率

生长的Q-networks:使用自适应控制解决方案解决连续的控制任务

主要关键词