机构名称:

¥ 2.0

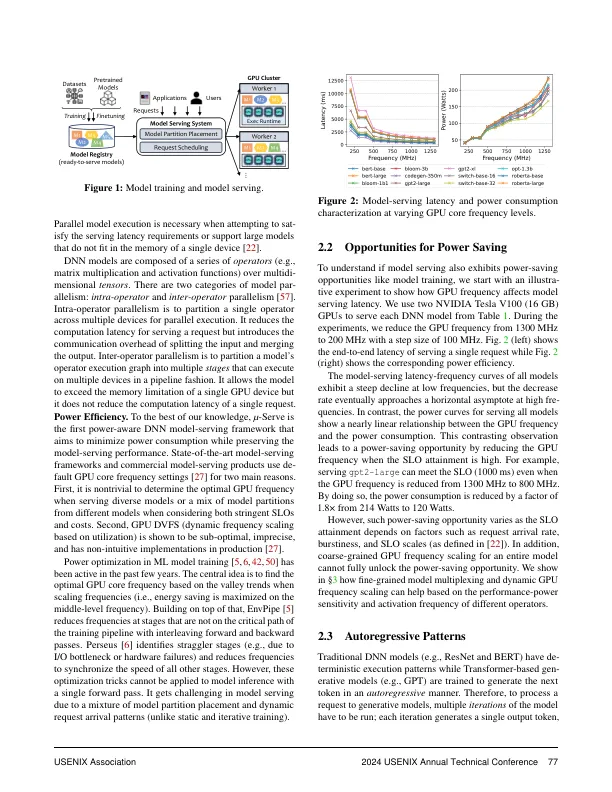

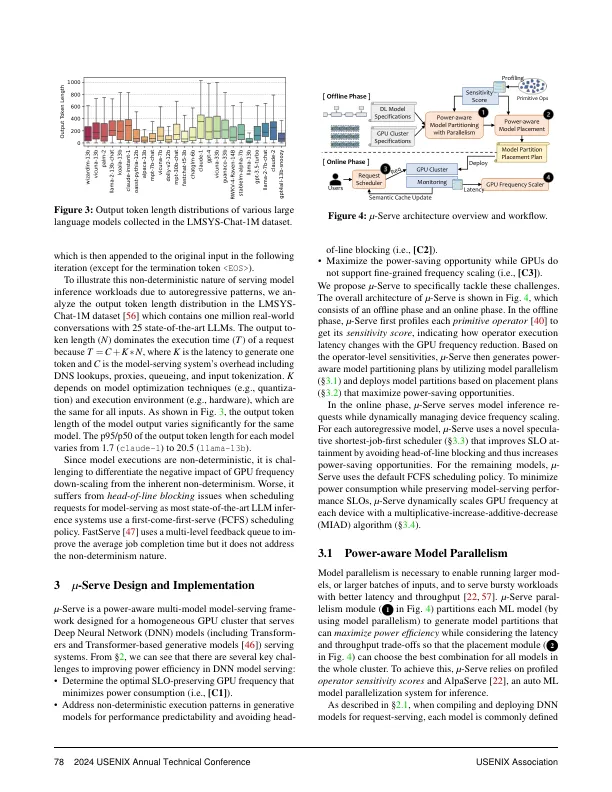

摘要随着大型深度学习模型的日益普及 - 服务工作量,迫切需要减少模型服务集群的能源消耗,同时对满足满足的吞吐量或模型服务的延迟需求。模型多路复用方法,例如模型阶段性,模型放置,复制和批处理旨在优化模型服务性能。但是,它们没有利用GPU频率缩放机会来节省。在本文中,我们证明了(1)GPU频率缩放在功率节省中用于模型服务的好处; (2)对细粒度模型多路复用和GPU频率缩放的共同设计和优化的必要性。我们探索了共同设计的空间,并提出了一种新型的功能感知模型服务系统µ-Serve。µ-Serve是一个模型服务框架,可优化在均质GPU群集中有效使用多个ML模型的功耗和吞吐量/吞吐量。生产工作负载的评估结果表明,通过动态GPU频率缩放(降低61%)而无需违反SLO的动态频率缩放(最多减少61%),可节省1.2–2.6倍的功率。

功率感知的深度学习模型与μ-Serve一起服务

主要关键词