机构名称:

¥ 1.0

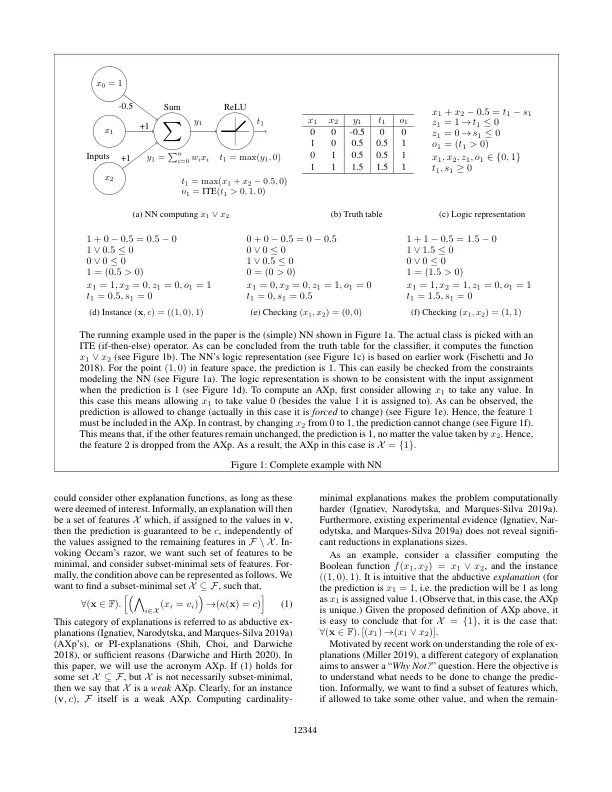

在高风险环境中部署人工智能 (AI) 系统需要可信赖的 AI。欧盟最近的指导方针和法规强调了这一关键要求,经合组织和联合国教科文组织的建议也强调了这一点,还有其他一些例子。可信赖 AI 的一个关键前提是必须找到能够提供可靠合理性保证的解释。本文认为,最著名的可解释 AI (XAI) 方法无法提供合理的解释,或者找到可能表现出显著冗余的解释。解决这些缺点的方法是提供形式严谨性保证的解释方法。这些正式解释不仅合理,而且保证无冗余。本文总结了形式化 XAI 这一新兴学科的最新发展。本文还概述了形式化 XAI 面临的现有挑战。

通过正式的XAI提供值得信赖的AI