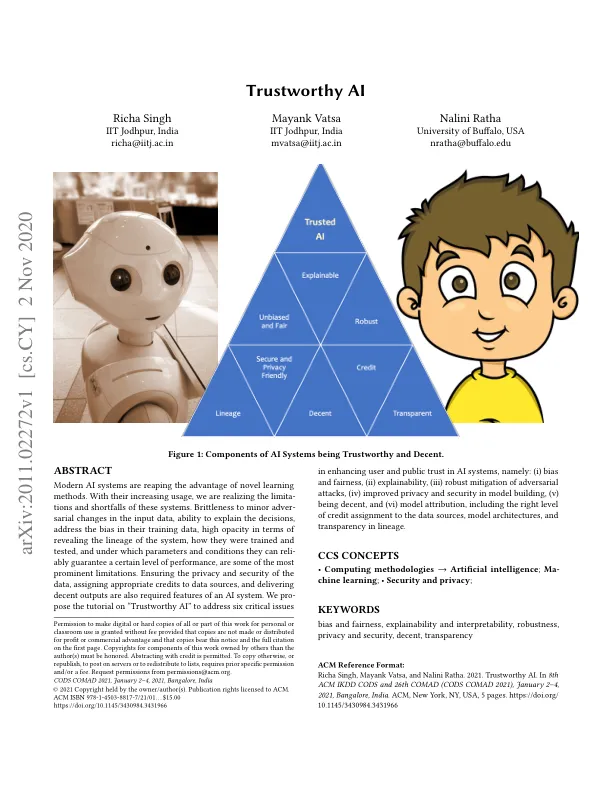

人工智能 (AI) 系统正在成为我们日常生活中不可或缺的一部分。它们不仅用于做出日常决策,例如健康食品选择和着装推荐,还用于做出重要且有影响力的决策,例如疾病诊断、检测金融欺诈和选拔新员工。它们在自动驾驶、自动金融贷款审批和癌症治疗建议等新兴应用中的部署日益广泛,这让许多人担心当今与 AI 相关的信任程度。这种担忧是真实的,因为在当前快速发展的 AI 系统中,对抗性攻击、偏见和缺乏可解释性已经暴露出现代 AI 系统的许多弱点。因此,构建“可信赖的 AI”系统的机制和方法非常重要。构建可信赖的 AI 系统需要了解模型是否有偏见。偏见一直是现代 AI 系统的一个关键致命弱点。从人脸识别到语言翻译,许多应用都显示出系统存在高度偏见,不同组和测试集之间的性能不一致就是明证。这对此类系统的公平性和可问责性有着重大影响,具有极其重大的社会影响。可解释性和可解释性是此类系统在许多不同情况下的必要条件,例如执法和医疗,在这些情况下,黑箱决策是不可接受的。尽管现代人工智能系统报告的准确度很高,但它们无法向人类解释其决策过程以及失败或成功案例的原因。除了高精度之外,隐私和安全对于人工智能的成功也至关重要。最近的研究表明,人工智能算法可以利用从社交媒体中提取的信息来对模糊的人脸进行去匿名化,并通过监控摄像头促进不必要的监视。此类人工智能应用既带来了挑战,也带来了机遇:虽然监控系统增强了个人和整个社会的安全,但它们易受攻击和破坏,也为滥用提供了机会。对抗性攻击尤其给用户带来了巨大的负面印象,认为人工智能系统很容易被欺骗。作为研究人员,我们需要建立和推广一个严格的框架来阐述对抗性机器学习中的问题,评估各种对抗性攻击下的影响和后果,并描述确保人工智能模型安全的属性。正如在许多领域所观察到的那样,开放性有助于释放更大的潜力。许多人工智能系统不披露模型的谱系、训练数据和性能细节。需要进行更多研究来解决系统披露的共同最低可接受做法。数据和模型归属是信任人工智能系统的关键组成部分。准确描述训练数据、架构和可靠的测试条件对于保证在预定义范围内的性能水平、设定用户期望以及潜在解释潜在偏差和故障至关重要。此外,特别是在由多个组件组成的复杂 AI 系统中,从一个特定模型中归因于给定的预测或信号对于可解释性和安全性至关重要。能够可靠地识别 AI 的签名

值得信赖的人工智能

主要关键词