机构名称:

¥ 1.0

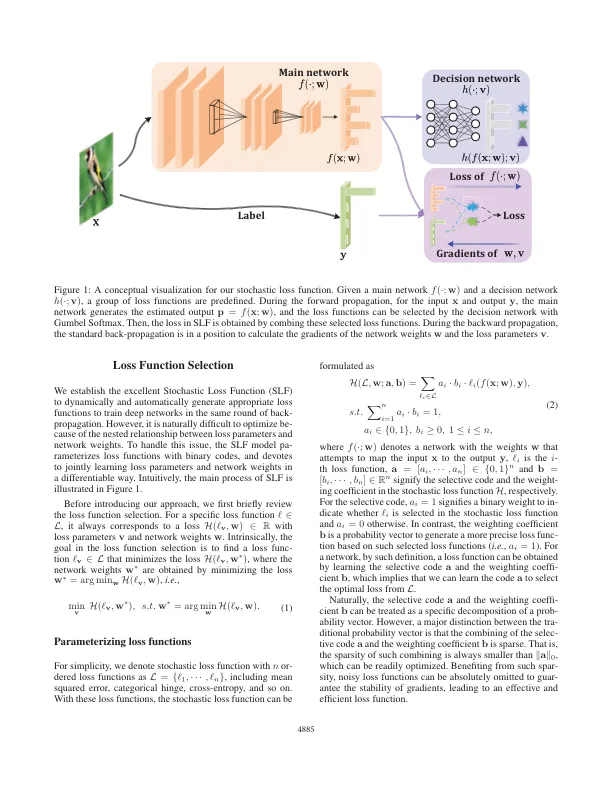

训练深度神经网络本质上受制于优化过程中预定义和固定的损失函数。为了提高学习效率,我们开发了随机损失函数 (SLF) 来动态地、自动地生成适当的梯度来在同一轮反向传播中训练深度网络,同时保持训练管道的完整性和可微分性。在 SLF 中,通用损失函数被表述为网络权重和损失参数的联合优化问题。为了保证必要的效率,利用相对于通用可微分损失的梯度来选择损失函数和优化网络权重。在各种流行数据集上进行的大量实验有力地证明了 SLF 能够在训练的不同阶段获得合适的梯度,并且可以显著提高各种深度模型在分类、聚类、回归、神经机器翻译和目标检测等现实世界任务上的性能。

随机损失函数

主要关键词