机构名称:

¥ 4.0

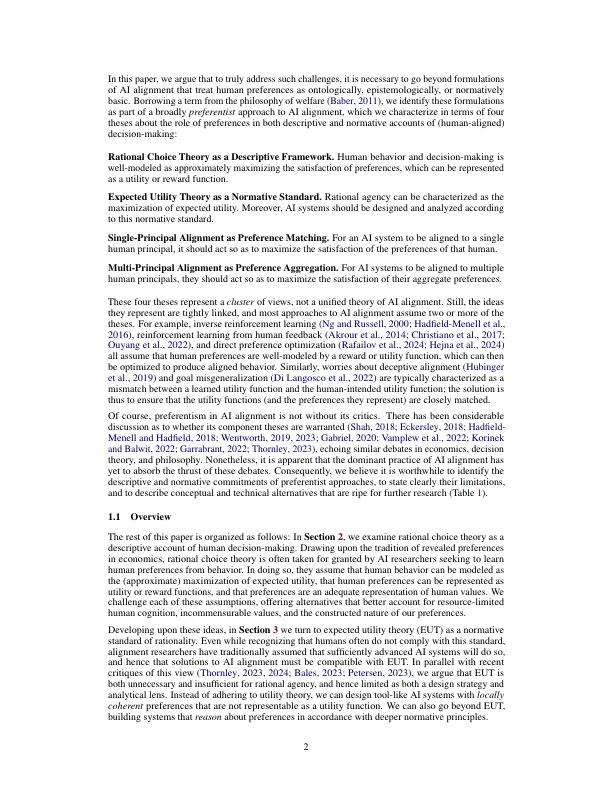

人工智能协调的主流实践假设 (1) 偏好是人类价值观的充分代表,(2) 人类理性可以从最大化偏好满足的角度来理解,(3) 人工智能系统应该与一个或多个人类的偏好保持一致,以确保它们的行为安全并符合我们的价值观。无论是隐含遵循还是明确认可,这些承诺都构成了我们所说的人工智能协调的偏好主义方法。在本文中,我们描述并挑战了偏好主义方法,描述了可供进一步研究的概念和技术替代方案。我们首先调查了理性选择理论作为描述性模型的局限性,解释了偏好如何无法捕捉人类价值观的深层语义内容,以及效用表示如何忽略了这些价值观可能存在的不可比性。然后,我们批评了预期效用理论 (EUT) 对人类和人工智能的规范性,借鉴了表明理性主体不必遵守 EUT 的论点,同时强调了 EUT 如何对哪些偏好在规范上是可接受的保持沉默。最后,我们认为这些限制促使我们重新定义人工智能协调的目标:人工智能系统不应与人类用户、开发者或人类的偏好保持一致,而应与适合其社会角色(例如通用助手的角色)的规范标准保持一致。此外,这些标准应由所有相关利益相关者协商并达成一致。根据这种替代的协调概念,多种人工智能系统将能够服务于不同的目的,与促进互利和限制伤害的规范标准保持一致,尽管我们的价值观多种多样。

超越人工智能对齐的偏好

主要关键词