机构名称:

¥ 1.0

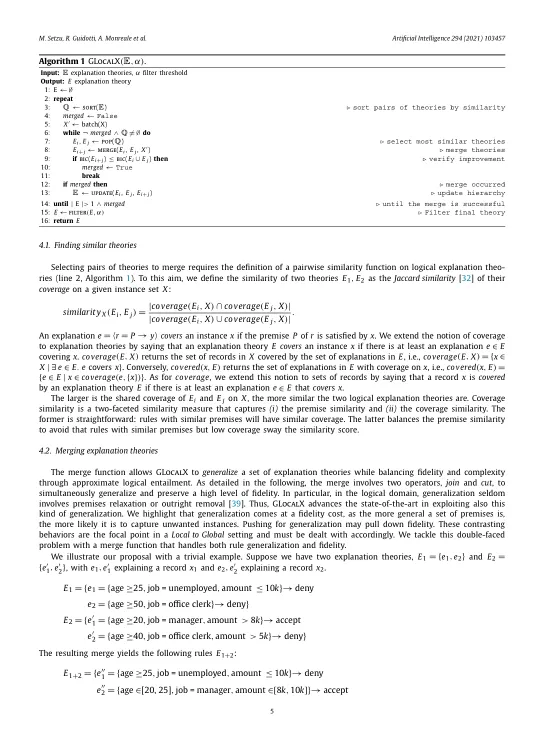

人工智能 (AI) 已成为我们社会的主要组成部分之一,其应用范围涵盖我们生活的方方面面。在这个领域,复杂且高度非线性的机器学习模型(例如集成模型、深度神经网络和支持向量机)在解决复杂任务方面始终表现出卓越的准确性。尽管准确,但人工智能模型通常是我们无法理解的“黑匣子”。依赖这些模型会产生多方面的影响,并引发对其透明度的重大担忧。敏感和关键领域的应用是尝试理解黑匣子行为的强大动机因素。我们建议通过聚合“局部”解释在黑匣子模型之上提供可解释层来解决此问题。我们提出了 GLocalX,一种“局部优先”模型不可知解释方法。从以局部决策规则形式表达的局部解释开始,GLocalX 通过分层聚合它们,将它们迭代地概括为全局解释。我们的目标是学习准确但简单且可解释的模型来模拟给定的黑匣子,并且在可能的情况下完全取代它。我们在标准和受限设置中的一组实验中验证了 GLocalX,这些实验对数据或本地解释的访问有限或根本没有访问。实验表明,GLocalX 能够使用简单和小型模型准确模拟多个模型,与原生全局解决方案相比达到最先进的性能。我们的研究结果表明,即使在具有高维数据的复杂领域中,也通常可以实现分类模型的高水平准确性和可理解性,而不必用一个属性换取另一个属性。这是值得信赖的人工智能的关键要求,对于高风险决策应用程序的采用必不可少。

本地化

主要关键词