机构名称:

¥ 3.0

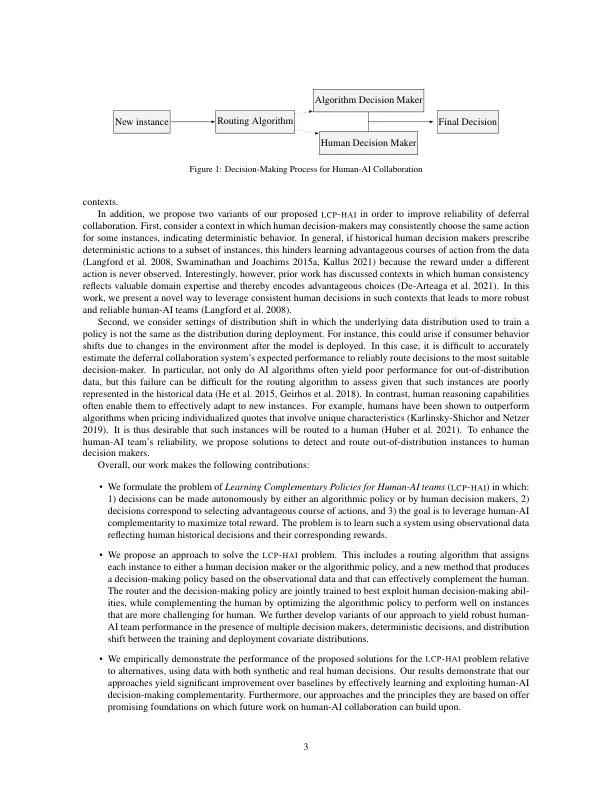

当算法和人类都无法在给定上下文中的所有实例中发挥主导作用时,人机互补性就很重要。最近探索人机协作的研究考虑了与分类任务相对应的决策。然而,在许多人类可以从人工智能互补性中受益的重要情况下,人类会采取行动。在本文中,我们提出了一种新颖的人机协作框架,用于选择有利的行动方案,我们将其称为人机团队的学习互补政策 (LCP - HAI)。我们的解决方案旨在利用人机互补性来最大化决策奖励,通过学习旨在补充人类的算法策略,通过使用路由模型将决策推迟给人类或人工智能以利用由此产生的互补性。然后,我们扩展了我们的方法来利用机会并降低实践中重要情况下出现的风险:1)当一个团队由多个具有差异和潜在互补能力的人组成时,2)当观察数据包括一致的确定性动作时,3)当未来决策的协变量分布与历史数据不同时。我们使用真实人类反应和半合成数据证明了我们提出的方法的有效性,并发现我们的方法在各种设置下都提供了可靠且有利的性能,并且优于算法或人工智能自己做出决策时。我们还发现,我们提出的扩展有效地提高了人机协作性能在不同挑战性设置下的稳健性。

学习人机团队的互补政策