机构名称:

¥ 1.0

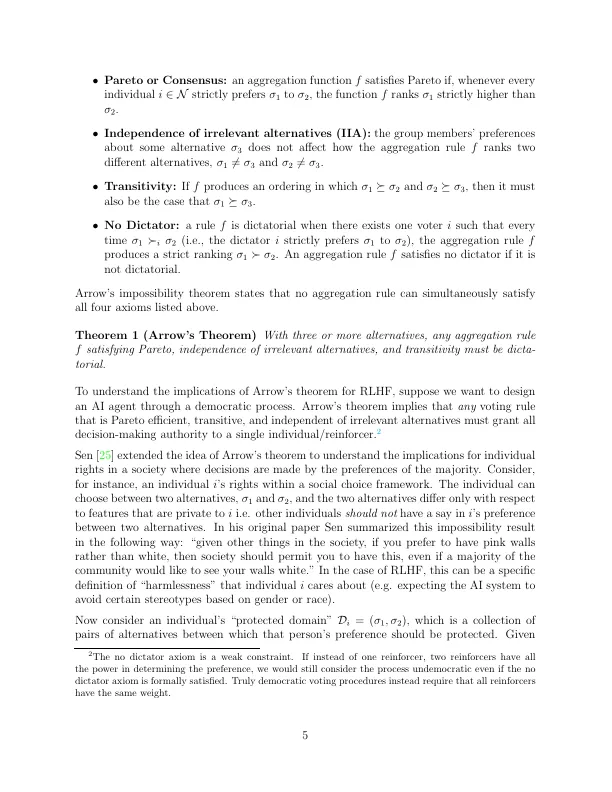

使人工智能代理与人类意图和价值观保持一致是构建安全且可部署的人工智能应用的关键瓶颈。但人工智能代理应该与谁的价值观保持一致?强化学习与人类反馈 (RLHF) 已成为人工智能对齐的关键框架。RLHF 使用来自人类强化器的反馈来微调输出;所有广泛部署的大型语言模型 (LLM) 都使用 RLHF 使其输出与人类价值观保持一致。了解 RLHF 的局限性并考虑由这些局限性引起的政策挑战至关重要。在本文中,我们研究了构建尊重民主规范的 RLHF 系统的一个特定挑战。基于社会选择理论中的不可能结果,我们表明,在相当广泛的假设下,没有独特的投票协议可以通过民主程序使用 RLHF 普遍对齐人工智能系统。此外,我们表明,使人工智能代理与所有个人的价值观保持一致将始终违反个人用户的某些私人道德偏好,即使用 RLHF 进行普遍的人工智能对齐是不可能的。我们讨论了使用 RLHF 构建的 AI 系统治理的政策含义:首先,需要强制执行透明的投票规则,以追究模型构建者的责任。其次,模型构建者需要专注于开发与特定用户群体紧密结合的 AI 代理。

人工智能协同与社会选择:根本限制和政策含义∗

主要关键词