机构名称:

¥ 1.0

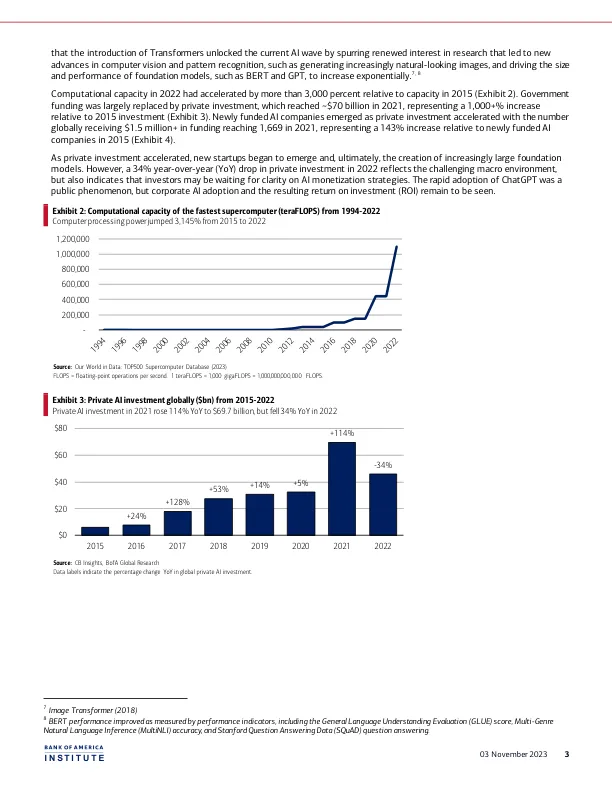

然而,Google Brain 于 2017 年发表的论文“Attention is All You Need”提出了一种名为 Transformer 的新型神经网络架构,该架构改进了长短期记忆等循环神经网络架构。5 Transformer 架构采用允许并行处理的自注意力机制,从而实现更高效的数据存储和计算,并减少训练和微调基础模型的时间和成本。6 BofA Global Research 的观点是 3 全面:专家系统的回报 (1989)。专家系统将 if/then 规则应用于数据以产生新的见解,并由德州仪器等公司实施,通过使某些流程快 20 倍并通过减少成本超支和准备费用平均每年减少 200 万美元开支,从而提高了生产力和效率。美国运通将其信贷授权人的效率提高了 45-67%。 4 微调是指使用结构化数据训练预训练模型的过程,以生成相对于原始模型而言性能更佳的专用应用程序,用于特定任务。 5 Transformer 模型还改进了 AI 应用程序的功能,因为神经网络(本质上是基础模型的大脑)能够更好地将语言语境化。例如,“bank”可能表示金融机构或河边,但查看句子中单词前后的上下文以确定含义会很有帮助。Transformer 模型通过使用句子中的所有单词(而不仅仅是之前的单词)来查找上下文,从而确定“bank”的含义。换句话说,该模型双向查找上下文,这就是“BERT”中“B”的含义。BERT 代表 Transformer 的双向编码器表示,是一种神经网络架构。 6 您所需要的只是注意力 (2017)

人工智能的进化:现实证明了炒作的合理性

主要关键词