机构名称:

¥ 4.0

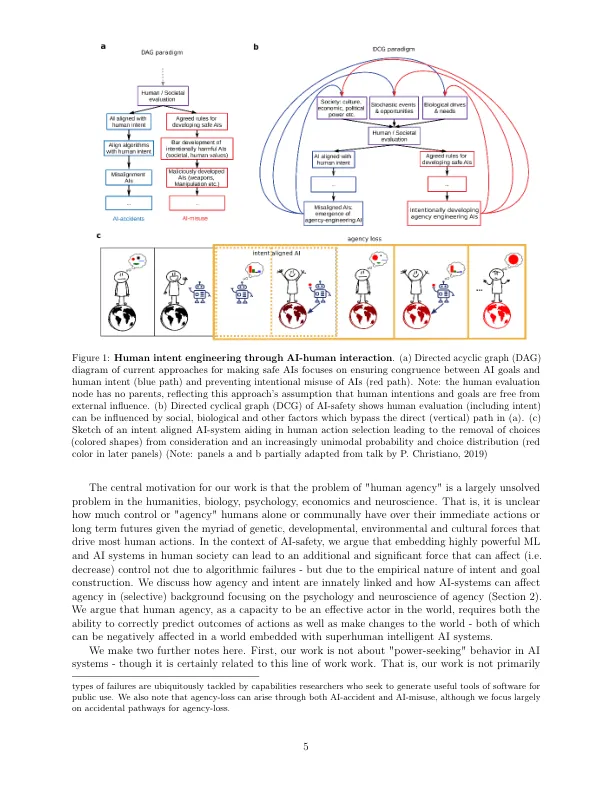

人工智能 (AI) 系统的快速发展表明,通用人工智能 (AGI) 系统可能很快就会到来。许多研究人员担心 AI 和 AGI 会通过故意滥用 (AI-misuse) 或意外事故 (AI-accidents) 伤害人类。关于 AI-accidents,人们越来越致力于开发算法和范例,以确保 AI 系统与人类的意图保持一致,例如,AI 系统产生的行动或建议可能被人类判断为与他们的意图和目标一致。在这里,我们认为,与人类意图保持一致不足以保证 AI 系统的安全,而长期保护人类的能动性可能是一个更强大的标准,需要在优化过程中明确和先验地将其分开。我们认为 AI 系统可以重塑人类的意图,并讨论了保护人类免于失去能动性的生物和心理机制的缺乏。我们提供了第一个保护能动性的 AI-人类互动的正式定义,该定义侧重于前瞻性的能动性评估,并认为 AI 系统(而不是人类)必须越来越多地承担这些评估的任务。我们展示了在包含嵌入式代理的简单环境中如何发生代理丧失,这些代理使用时间差分学习来提出行动建议。最后,我们提出了一个名为“代理基础”的新研究领域,并提出了四个旨在提高我们对人工智能与人类互动中代理的理解的初始主题:仁慈博弈论、人权的算法基础、神经网络中代理表示的机械可解释性和从内部状态进行强化学习。

意图一致的人工智能系统会削弱人类的能动性

主要关键词