机构名称:

¥ 1.0

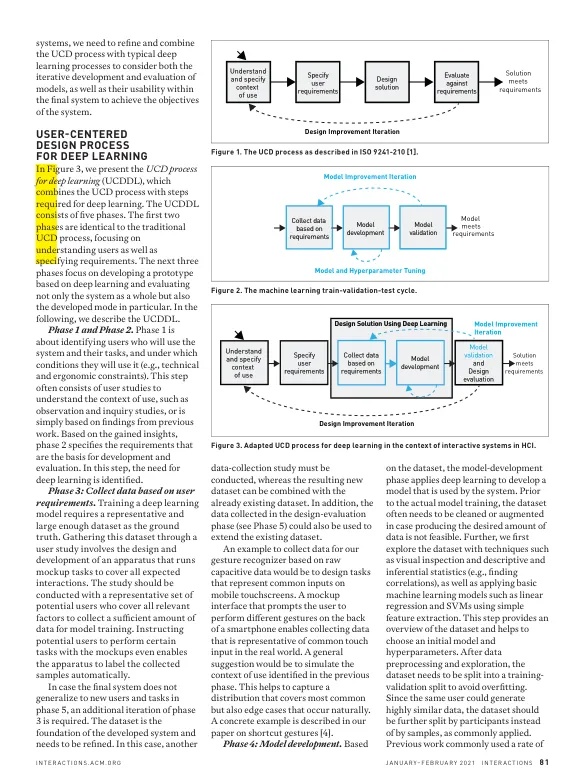

研究。数据集应代表各种用户和不同的上下文,以捕获各种变化。之后,我们需要准备数据并训练模型。训练将重复一百甚至一千次,以找到最合适的模型结构和超参数,这些模型结构和超级参数会导致使用试用和误差或网格搜索的测试集中最低模型误差。由于成千上万的迭代可能导致对测试集的过度拟合,因此必须使用先前看不见的数据评估模型的推广性,以评估所选模型和超参数是否已过拟合到验证集或推广到看不见的数据。深度学习社区在开发模型时通常会使用训练验证测试分解。在训练集和验证集用于迭代模型开发时,测试集用于一次性验证模型。但是,传统的机器学习评估指标(例如,准确性,精度,召回和错误率,以描述模型对看不见的数据的推广程度)并不描述系统的可用性。UCD过程的主要重点是实现高可用性。而不是软件指标,例如推理错误对可用性,模型稳定性和研究系统的有用性等因素。这可能涉及基本问题,例如对给定用例感知的可用性以及影响力的影响程度以及随着时间的推移估计的噪音多么嘈杂。在互动中应用深度学习技术由于系统使用了多种用户,在不同的情况下,验证还需要评估该模型是否可以推广到数据收集研究中使用的任务。虽然先前的工作认为准确性超过80%以至于足够[6],但充分性取决于用例,只能通过用户反馈来评估,例如,该动作的后果是否可恢复以及后果对用户的影响有多大。总而言之,一个深度学习的典型过程描述了开发和评估黑盒模型的迭代性质。但是,深度学习开发过程并未考虑模型的可用性以及最终系统的可用性。

人类计算机互动的深度学习

主要关键词