机构名称:

¥ 1.0

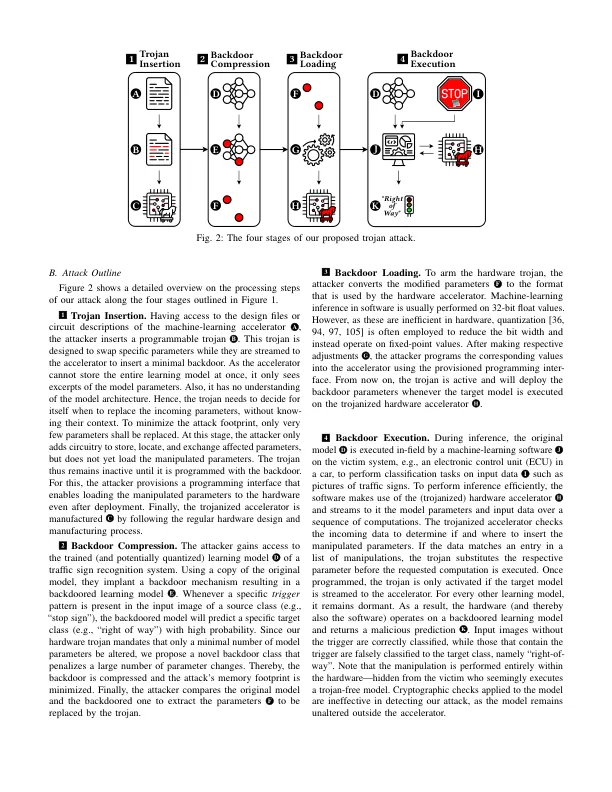

摘要 - 后门对机器学习构成了严重威胁,因为它们会损害安全系统的完整性,例如自动驾驶汽车。虽然已经提出了不同的防御来解决这一威胁,但他们都依靠这样的假设:硬件加速器执行学习模型是信任的。本文挑战了这一假设,并研究了完全存在于这样的加速器中的后门攻击。在硬件之外,学习模型和软件都没有被操纵,以使当前的防御能力失败。作为硬件加速器上的内存有限,我们使用的最小后门仅通过几个模型参数偏离原始模型。为了安装后门,我们开发了一个硬件特洛伊木马,该木马会处于休眠状态,直到在现场部署后对其进行编程。可以使用最小的后门来配置特洛伊木马,并仅在处理目标模型时执行参数替换。我们通过将硬件特洛伊木马植入商用机器学习加速器中,并用最小的后门来证明攻击的可行性,以使其对交通符号识别系统进行编程。后门仅影响30个模型参数(0.069%),后门触发器覆盖了输入图像的6.25%,但是一旦输入包含后门触发器,它就可以可靠地操纵识别。我们的攻击仅将加速器的电路大小扩大了0.24%,并且不会增加运行时,几乎不可能进行检测。鉴于分布式硬件制造过程,我们的工作指出了机器学习中的新威胁,该威胁目前避免了安全机制。索引术语 - 硬件木马,机器学习后门。

内部邪恶:通过休眠硬件Trojans的机器学习后门

主要关键词