机构名称:

¥ 1.0

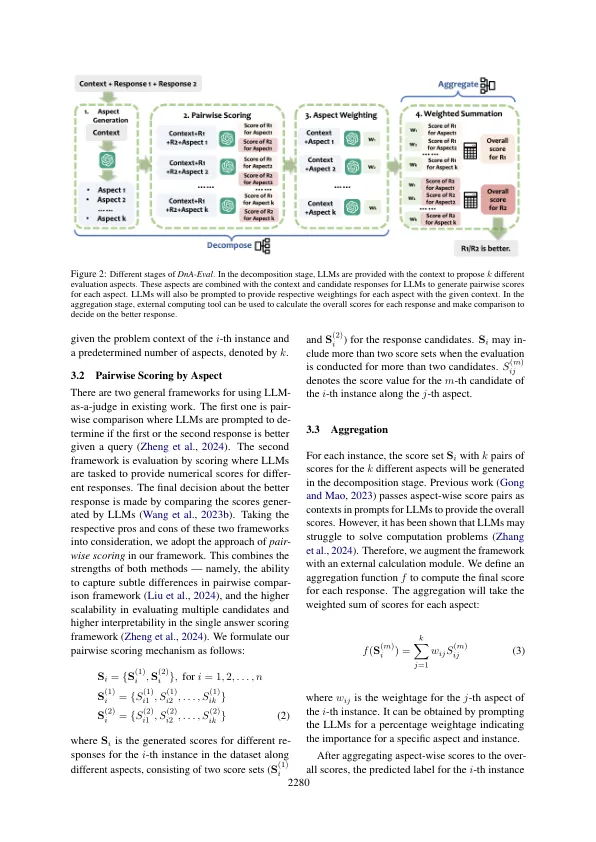

大型语言模型(LLMS)研究的加速度为评估生成的文本开辟了新的可能性。尽管LLM是可扩展和经济的评估者,但这些评估者的可靠性仍然不足。在法官将LLM的提示限制为单一用途以获得最终评估决定时,在元评估中进行了元评估。 然后,他们计算LLMS的输出和Human标签之间的一致性。 这缺乏理解LLM的评估能力的解释性。 鉴于这一挑战,我们提出了DNA-eval,它将评估过程分解为基于教学实践的分解和聚集阶段。 我们的实验表明,它不仅为LLMS评估的评估提供了一个更容易解释的窗口,而且还可以在各种元评估台上的不同LLM中改善高达39.6%的窗口。在元评估中进行了元评估。然后,他们计算LLMS的输出和Human标签之间的一致性。这缺乏理解LLM的评估能力的解释性。鉴于这一挑战,我们提出了DNA-eval,它将评估过程分解为基于教学实践的分解和聚集阶段。我们的实验表明,它不仅为LLMS评估的评估提供了一个更容易解释的窗口,而且还可以在各种元评估台上的不同LLM中改善高达39.6%的窗口。

DNA-eval:通过分解和聚合增强大语模型评估

主要关键词