机构名称:

¥ 1.0

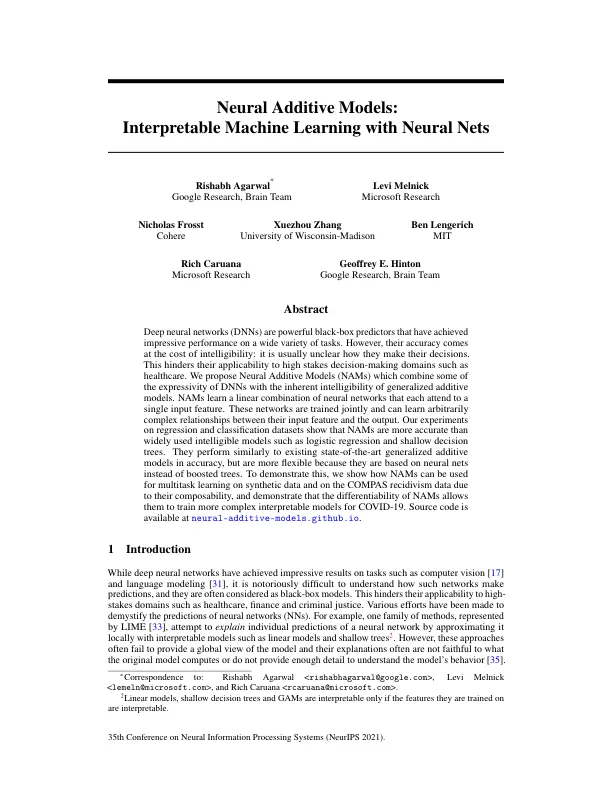

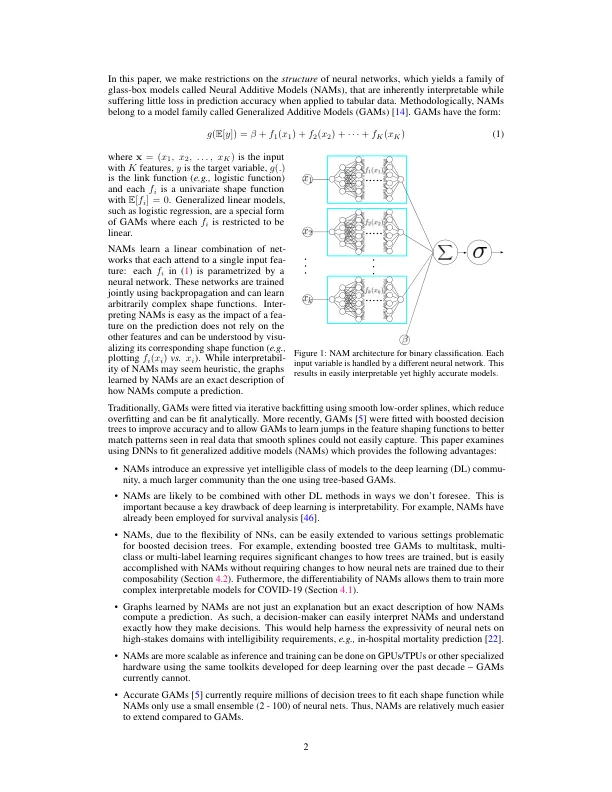

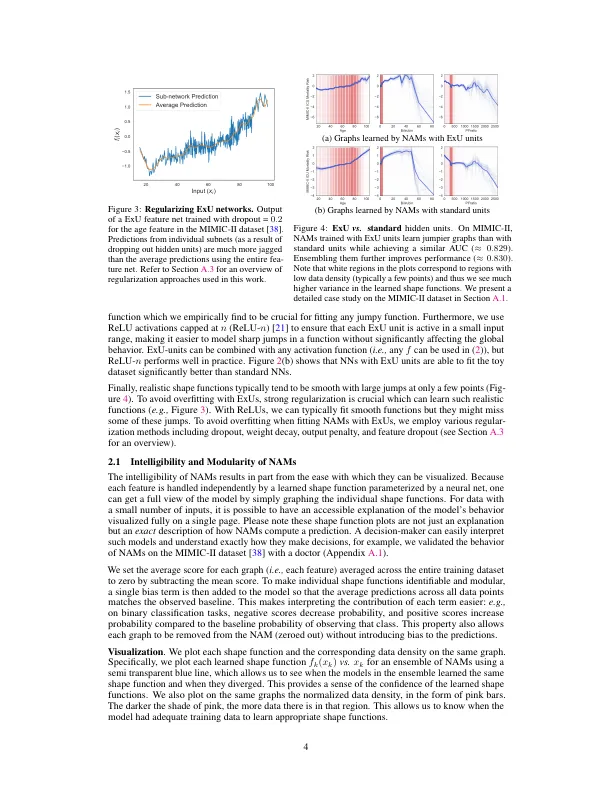

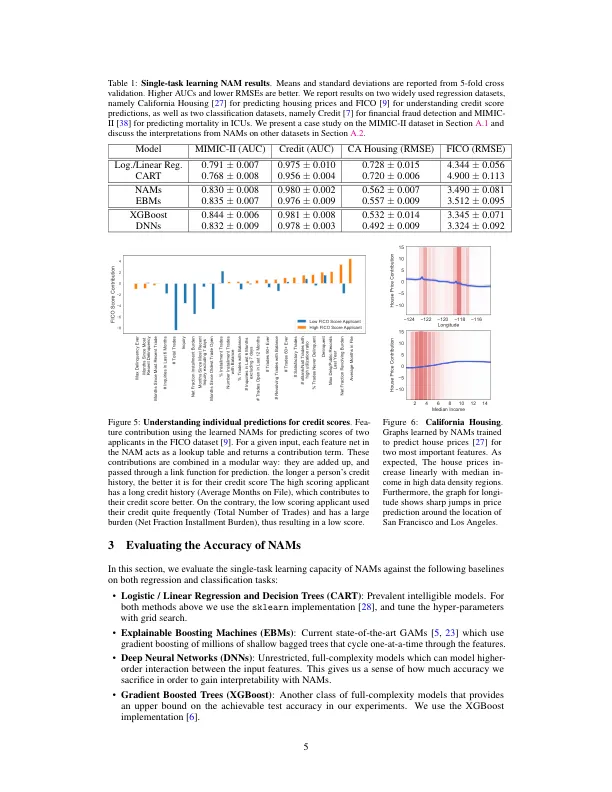

深度神经网络 (DNN) 是功能强大的黑盒预测器,在各种任务上都取得了令人印象深刻的表现。然而,它们的准确性是以牺牲可理解性为代价的:通常不清楚它们如何做出决策。这阻碍了它们在医疗保健等高风险决策领域的适用性。我们提出了神经加性模型 (NAM),它将 DNN 的一些表达能力与广义加性模型固有的可理解性相结合。NAM 学习神经网络的线性组合,每个神经网络都关注一个输入特征。这些网络是联合训练的,可以学习输入特征和输出之间任意复杂的关系。我们在回归和分类数据集上的实验表明,NAM 比广泛使用的可理解模型(如逻辑回归和浅层决策树)更准确。它们在准确性方面的表现与现有的最先进的广义加性模型相似,但更灵活,因为它们基于神经网络而不是增强树。为了证明这一点,我们展示了如何利用 NAM 对合成数据和 COMPAS 累犯数据进行多任务学习(由于其可组合性),并证明了 NAM 的可微分性使它们能够为 COVID-19 训练更复杂的可解释模型。源代码可在 neuro-additive-models.github.io 上找到。

神经加法模型:利用神经网络进行可解释的机器学习

主要关键词