机构名称:

¥ 1.0

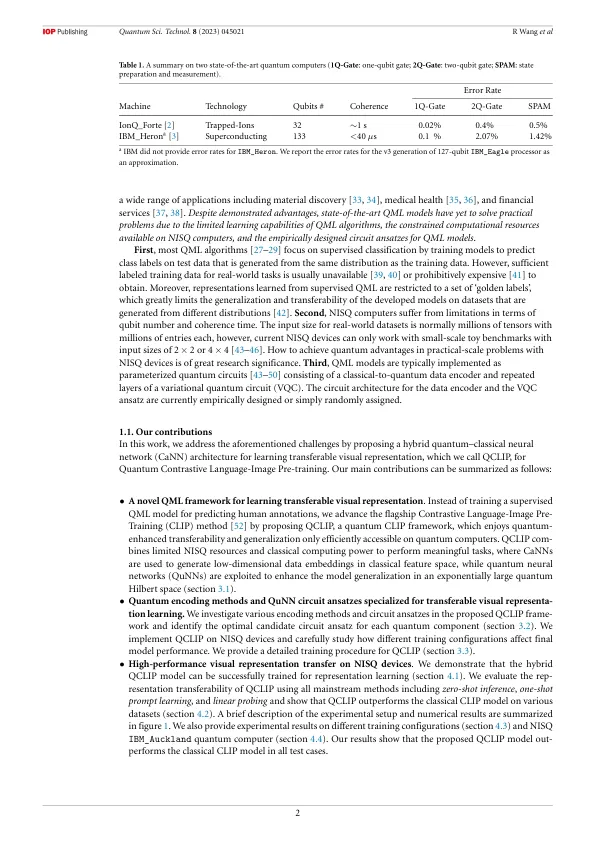

摘要 由于 QML 算法的学习能力有限、当今嘈杂的中型量子 (NISQ) 设备上可用的计算资源有限以及 QML 模型的经验设计电路假设,最先进的量子机器学习 (QML) 算法未能提供比其众所周知的强大的经典算法更好的实际优势。在这项工作中,我们通过提出一种混合量子-经典神经网络 (CaNN)(我们称之为 QCLIP)来解决这些挑战,用于量子对比语言-图像预训练。QCLIP 不是训练监督式 QML 模型来预测人类注释,而是专注于更实用的可转移视觉表征学习,其中开发的模型可以推广到看不见的下游数据集。QCLIP 是通过使用 CaNN 生成低维数据特征嵌入,然后使用量子神经网络来调整和推广量子希尔伯特空间中学习到的表征来实现的。实验结果表明,混合 QCLIP 模型可以有效地进行表征学习训练。我们在各种数据集上评估了 QCLIP 与经典对比语言图像预训练模型的表征迁移能力。NISQ IBM_Auckland 量子计算机上的模拟结果和真实设备结果均表明,所提出的 QCLIP 模型在所有测试用例中均优于经典 CLIP 模型。随着 NISQ 设备上的 QML 领域不断发展,我们预计这项工作将为这一前景广阔的领域的未来研究和进步奠定宝贵的基础。

用于学习可转移视觉表征的混合量子-经典神经网络

主要关键词