机构名称:

¥ 1.0

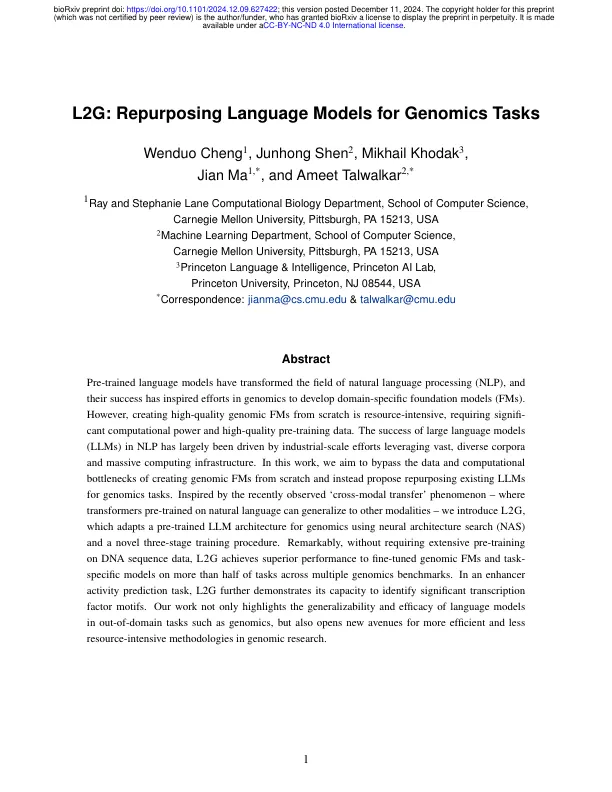

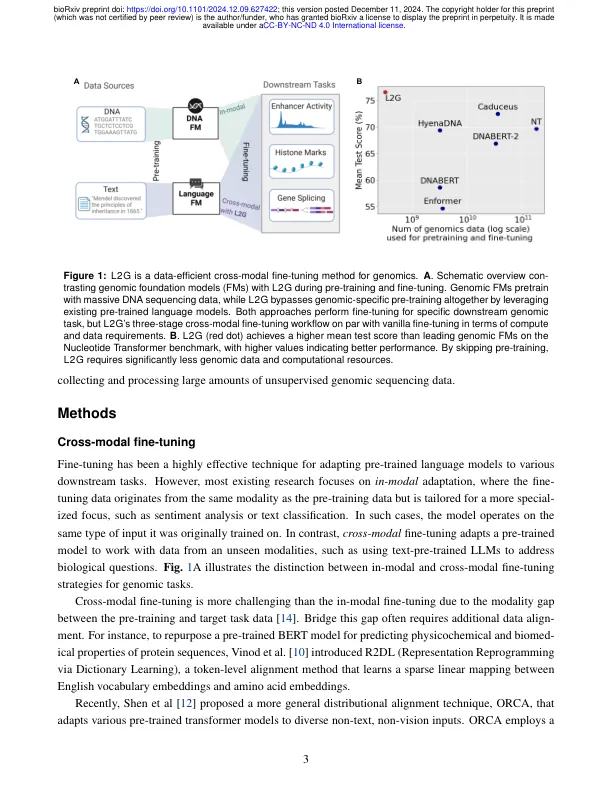

预训练语言模型已经改变了自然语言处理 (NLP) 领域,它们的成功激发了基因组学领域开发特定领域基础模型 (FM) 的努力。然而,从头开始创建高质量的基因组 FM 需要大量资源,需要强大的计算能力和高质量的预训练数据。大型语言模型 (LLM) 在 NLP 中的成功很大程度上是由工业规模的努力推动的,这些努力利用了庞大、多样化的语料库和海量计算基础设施。在这项工作中,我们旨在绕过从头开始创建基因组 FM 的数据和计算瓶颈,而是建议将现有的 LLM 重新用于基因组学任务。受最近观察到的“跨模态转移”现象的启发——在自然语言上预训练的转换器可以推广到其他模态——我们引入了 L2G,它使用神经架构搜索 (NAS) 和一种新颖的三阶段训练程序将预训练的 LLM 架构调整为基因组学。值得注意的是,无需对 DNA 序列数据进行大量预训练,L2G 在多个基因组学基准测试中超过一半的任务上都比经过微调的基因组 FM 和任务特定模型表现优异。在增强子活性预测任务中,L2G 进一步展示了其识别重要转录因子基序的能力。我们的工作不仅突出了语言模型在基因组学等域外任务中的通用性和有效性,还为基因组研究中更高效、资源密集程度更低的方法开辟了新途径。

L2G:重新利用语言模型来执行基因组学任务

主要关键词