机构名称:

¥ 1.0

1引言作为可解释的AI(XAI)的领域已经成熟,反对解释(CES)已成为解释AI模型的主要事后方法之一(例如,请参见,例如,参见,例如[Karimi等。,2022]用于概述)。ces通常被提倡作为为受到机器学习模型决定影响的个人提供追索权的一种手段。特别是,给定对M模型M的输入X,CE基本上向用户展示了一个新的,稍微修改的输入X',这表明如果将所做的更改应用于X,则如何实现不同的结果。为了插图,将虚构的贷款申请与功能收入£50 K,贷款期限为35个月,贷款金额£10 K被模型拒绝。在此示例中,CE可以证明将收入提高到55英镑将导致申请被接受。鉴于部署了CE的许多情况的批判性质,例如在财务或医疗环境中,他们提供的追索权是最重要的,即它给出了预期的结果变化,从而给予了信任。然而,最近的工作表明,在鲁棒性方面,获得CES的最新方法是获得主要缺点,即在不断变化的条件下,它们产生的CE的有效性。,特别是[Pawelczyk等。,2022年]表明,生成CE的流行方法可能会返回与对抗性例子没有区别的解释。广泛地说,这意味着CES

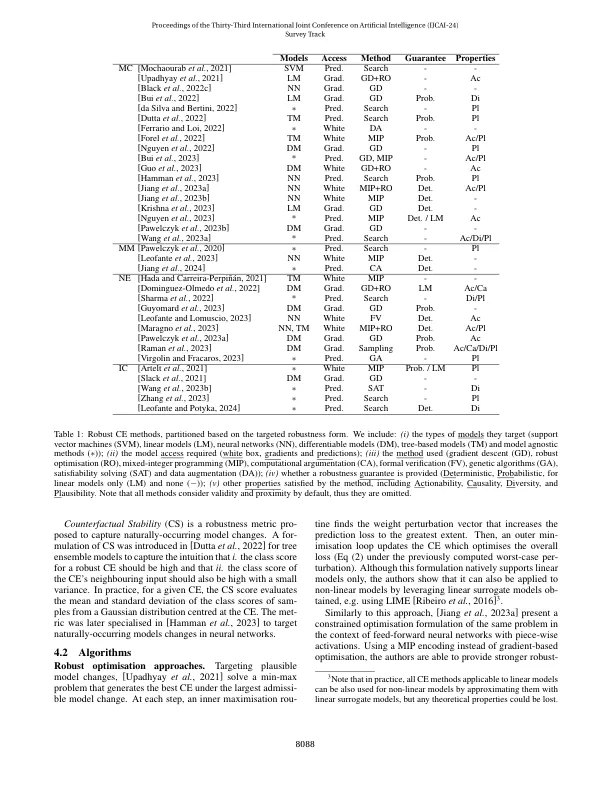

机器学习中强大的反事实解释

主要关键词