机构名称:

¥ 1.0

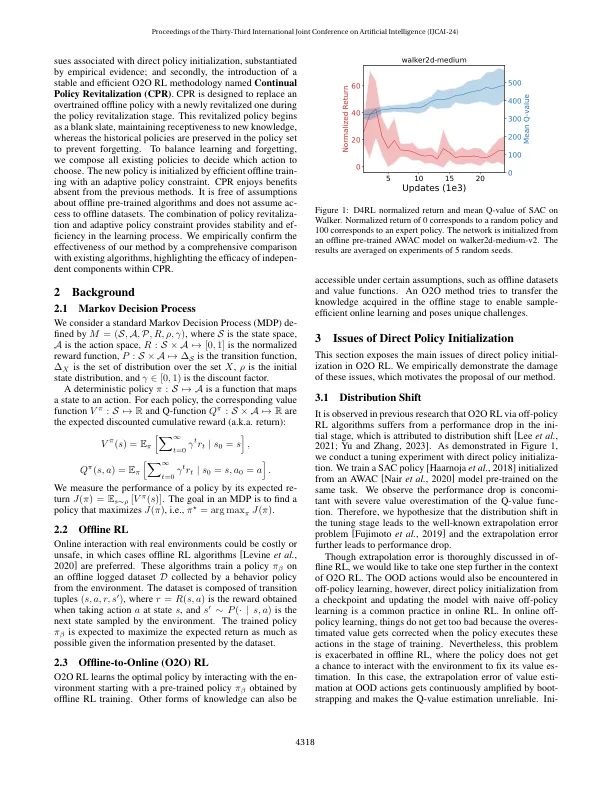

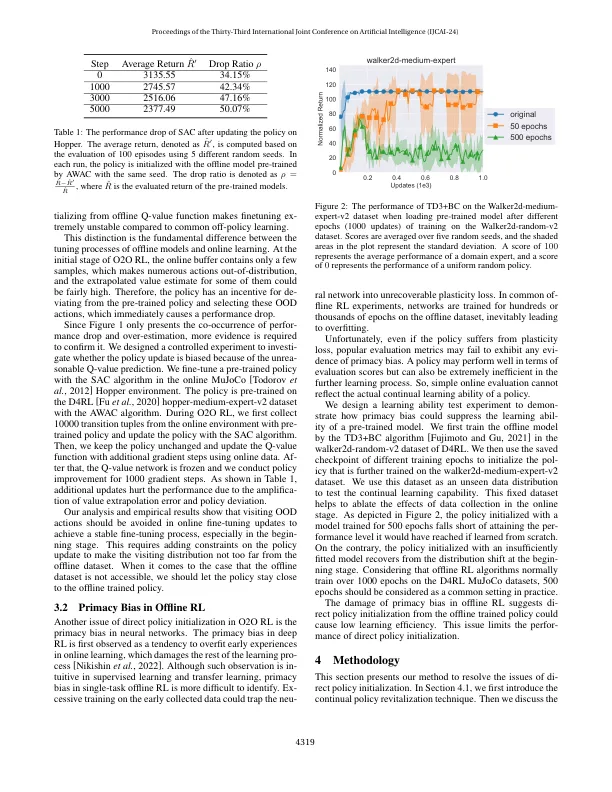

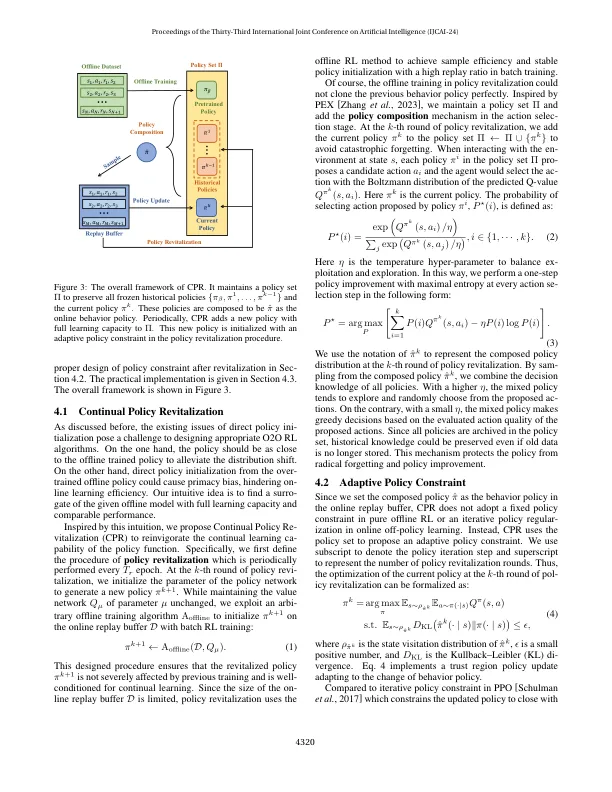

在离线增强学习(RL)中,预先训练的政策用于初始化和随后的在线微调。但是,与纯在线学习相比,现有方法遭受不稳定性和样本效率低。这是通过使用离线训练的策略模型来确定这些限制的这些限制。我们提出持续的政策振兴(CPR)是一种新型的高效,稳定的微调方法。CPR结合了一种定期的政策修订技术,将过度训练的政治网络恢复到完全学习能力,同时确保稳定的初始性能。这种方法可以进行微调,而不会受到低质量预训练政策的不利影响。与预先研究的研究相比,CPR在政策优化中具有自适应政策约束的新政策初始化。这种优化使新的政策与历史政治制定的行为政策接近。这有助于稳定的政策改进和最佳融合性能。实际上,CPR可以通过最小的修改无缝地集成到现有的离线RL算法中。我们通过广泛的实验来核心验证我们的方法的有效性,证明了与以前的方法相比,学习稳定性和效率的基础改善。我们的代码可在https://github.com/lamda-rl/cpr上找到。

通过持续的政策振兴

主要关键词