机构名称:

¥ 1.0

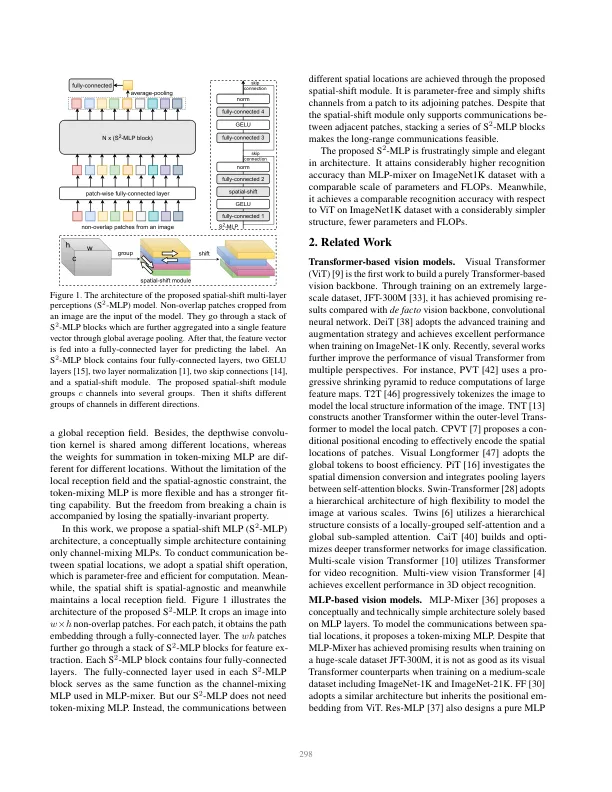

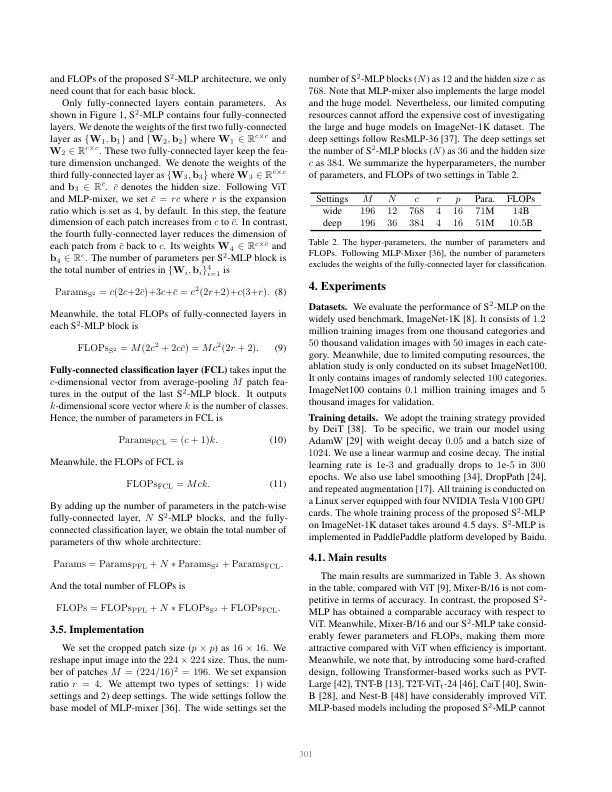

最近,Visual Transformer(VIT)及其以下作品放弃了卷积,并利用了自我发项操作,比CNN获得了可比甚至更高的精度。最近,MLP-Mixer放弃了卷积和自我发项操作,提出了仅包含MLP层的体系结构。为了实现交叉补丁通信,除了通道混合MLP外,它还设计了其他令牌MLP。在诸如JFT-300M之类的极限数据集上进行训练时,它会取得令人鼓舞的结果。,但是当在ImagEnet-1k等中等规模的数据集上训练时,它的表现不如其CNN和VIT对应。MLP混合使用的性能下降激励我们重新考虑令牌混合MLP。我们发现,MLP混合中的令牌混合操作是深度卷积的变体,具有全局接收场和空间特异性配置。在本文中,我们提出了一种新颖的纯MLP体系结构,即空间移位MLP(S 2 -MLP)。不同于MLP混合器,我们的S 2 -MLP仅包含通道混合MLP。我们设计了一个空间换档操作,以实现通过补丁之间的通信。它具有局部接收场,是空间的 - 不可知论。同时,它无参数且有效地计算。在Imagenet-1K数据集训练时,提出的S 2 -MLP比MLP混合剂具有更高的识别精度。同时,S 2 -MLP在ImageNet-1k数据集上具有出色的性能,具有更简单的架构,较少的失败和参数。

s2-MLP:视觉的空间移位MLP体系结构

主要关键词