机构名称:

¥ 1.0

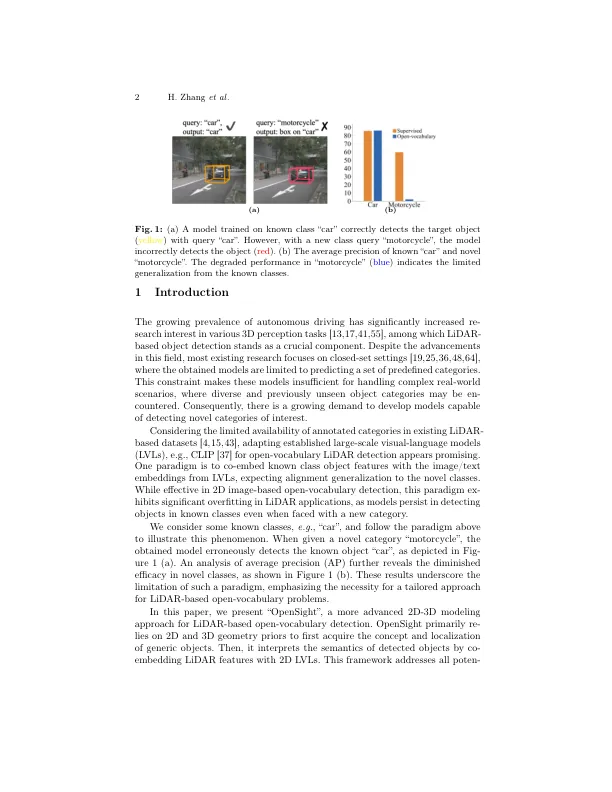

摘要。传统的基于LIDAR的对象检测研究的基础侧重于封闭场景,该场景在复杂的现实世界应用中差不多。直接将现有的2D开放式视频计学模型转移到具有一些已知的LiDAR类别以进行开放式摄氏度的能力,但往往会遇到过度拟合的问题:获得的模型将检测到已知的对象,甚至呈现出新的类别。在本文中,我们提出了Opensight,这是一种基于激光雷达的开放式摄影检测的更高级的2D-3D建模框架。Opensight利用2D-3D几何先验来进行通用观察的初始识别和定位,然后对检测到的对象进行了更具体的语义解释。该过程首先从LIDAR的随附的相机图像中生成2D框。用LiDar点的这些2D盒子将其抬起回到激光雷达空间中,以估算相应的3D盒子。为了获得更好的通用对象感知,我们的框架都集成了时间和空间感知的约束。时间意识将连续时间戳跨预测的3D框关联,从而重新校准了错过或不准确的框。空间意识随机将一些“精确”估计的3D框以不同的距离估计,从而增加了通用对象的可见性。要解释检测到的对象的特定语义,我们开发了一个跨模式对齐和融合模块,以将3D特征与2D图像嵌入,然后融合为语义解码的对齐的3D-2D特征。我们的实验表明,我们的方法在广泛使用的3D检测基准上建立了最先进的开放式摄影性能,并有效地识别了对新类别感兴趣的对象。

Opensight:基于LIDAR的对象检测的简单开放式摄影框架

主要关键词