机构名称:

¥ 1.0

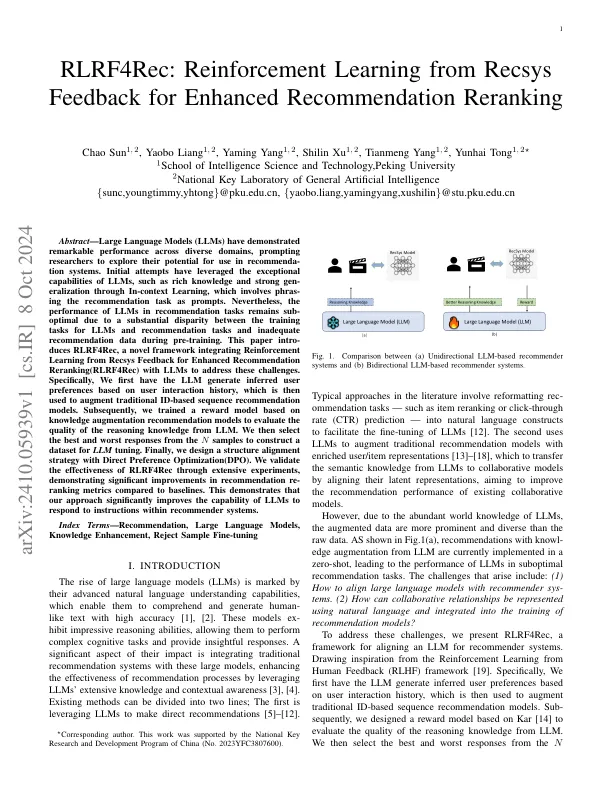

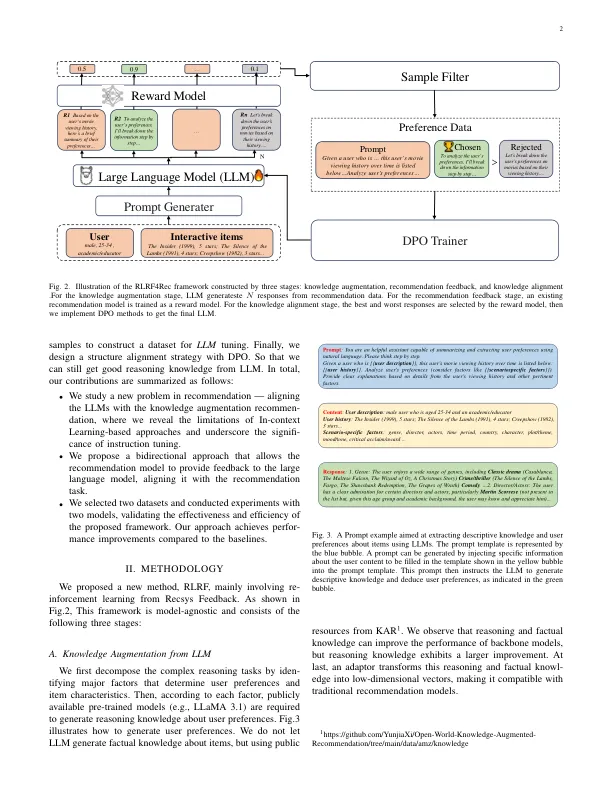

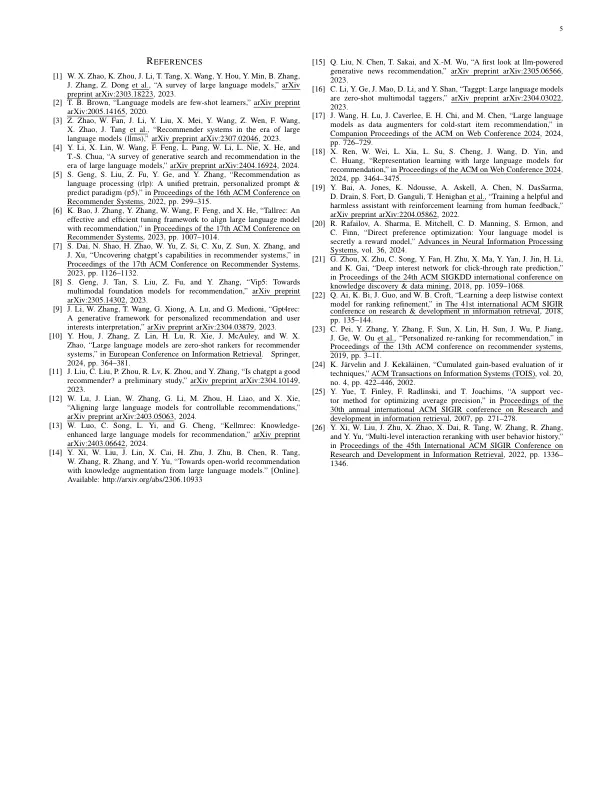

摘要 - LARGE语言模型(LLMS)在不同领域表现出了出色的性能,促使研究人员探索其在推荐系统中使用的潜力。最初的尝试利用了LLM的特殊功能,例如通过文本学习丰富的知识和强大的实现,这涉及将建议任务作为提示。尽管如此,由于LLMS的培训任务与建议任务的培训任务之间存在很大的差异,并且在预训练期间的建议数据不足,因此LLM在推荐任务中的性能仍然是最佳的。本文Intro-duces rlrf4rec是一个新颖的框架,该框架整合了从recsys反馈中学习的增强框架,以增强推荐的重新推荐(RLRF4REC)与LLMS解决这些挑战。具体来说,我们首先具有基于用户交互历史记录的LLM生成推断的用户偏好,然后将其用于增强传统的基于ID的序列推荐模型。随后,我们基于知识增强建议模型培训了奖励模型,以评估LLM的推理知识质量。然后,我们从N样品中选择最佳和最差的响应来构建用于LLM调整的数据集。最后,我们设计了一种具有直接偏好优化(DPO)的结构对齐策略。我们通过广泛的实验验证了RLRF4REC的有效性,与基准相比,建议指标的建议量度有显着改善。这表明我们的方法显着提高了LLM响应推荐系统中指令的能力。

RLRF4REC:从recsys反馈中学习增强建议

主要关键词