机构名称:

¥ 2.0

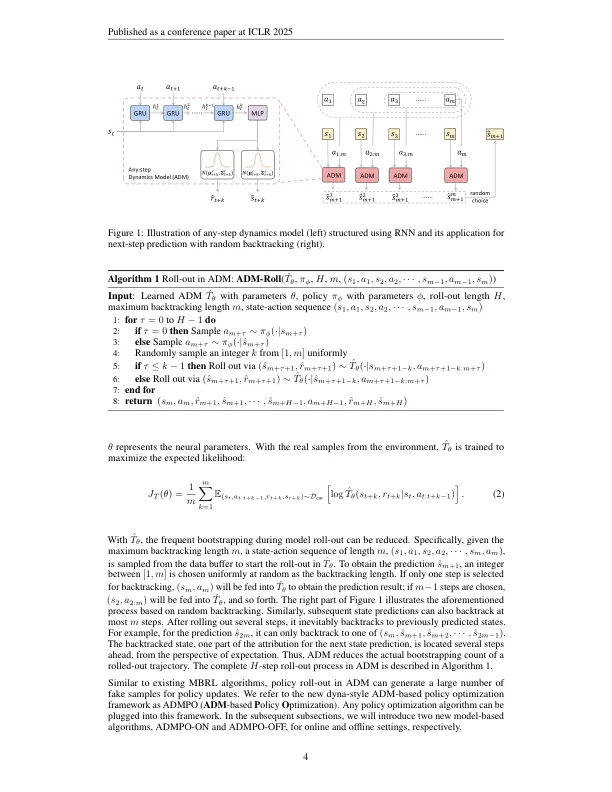

基于模型的增强学习方法提供了一种有希望的方法来通过促进动态模型中的政策探索来提高数据效率。但是,由于自举预测,在动力学模型中准确预测的顺序步骤仍然是一个挑战,该预测将下一个状态归因于当前状态的预测。这会导致模型推出期间积累的错误。在本文中,我们提出了ny-step d ynamics m odel(adm),以通过将引导预测减少为直接预测来减轻复合误差。ADM允许将可变长度计划用作预测未来状态的输入,而无需频繁地引导。我们设计了两种算法,即ADMPO-ON和ADMPO-OFF,它们分别适用于在线和离线模型的框架中。在在线设置中,与以前的最新方法相比,ADMPO-ON显示出提高的样品效率。在离线设置中,与最近最新的离线方法相比,ADMPO不仅表现出优异的性能,而且还可以更好地使用单个ADM来更好地了解模型不确定性。该代码可在https://github.com/lamda-rl/admpo上找到。

任何步骤动态模型都改善了未来的pre

主要关键词