机构名称:

¥ 1.0

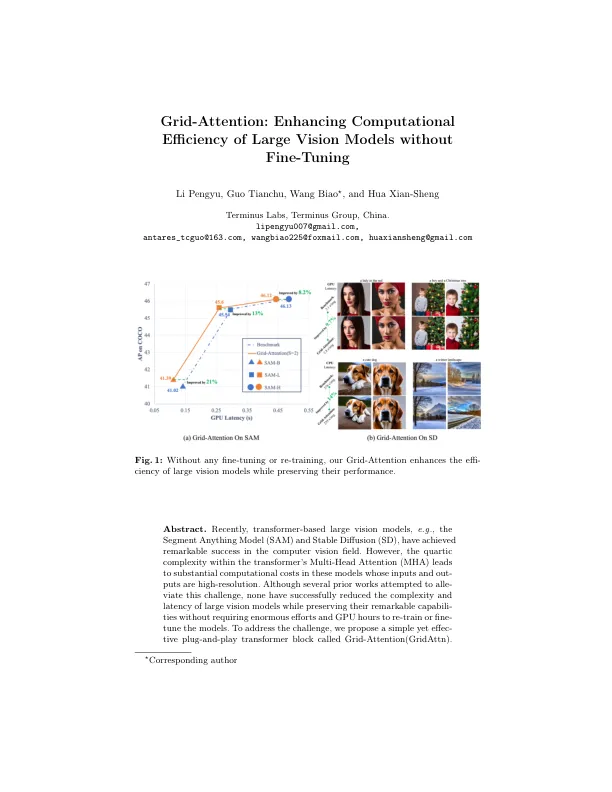

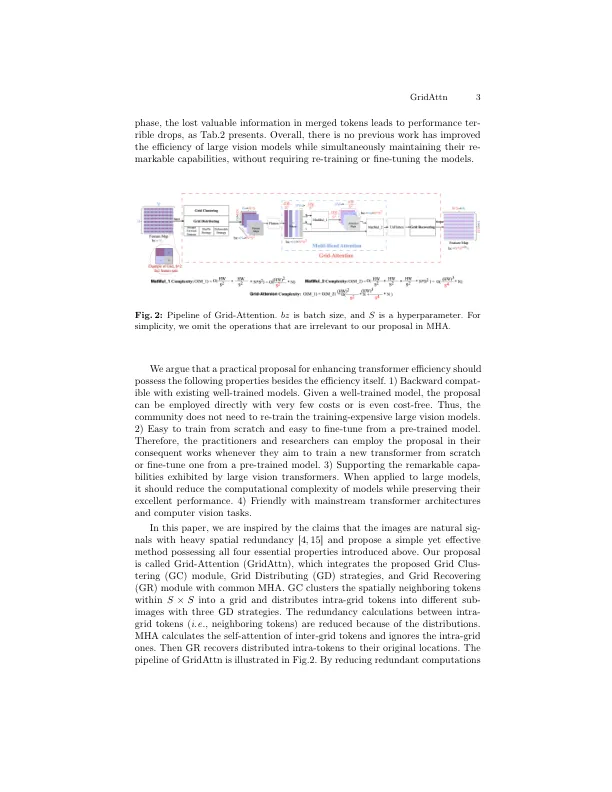

Gridattn集成了提出的网格聚类模块,网格分配策略以及将网格恢复模块与常见的MHA相结合,以提高大型视力模型的计算效率并保持其性能,而无需重新训练或对其参数进行微调。我们对最近的高分辨率任务进行了广泛的实验,包括零摄像实例分割(SAM,Expedit-SAM),文本到图像生成(稳定扩散v2.1)和语义segmentation(segformer b0-b5)。实验表明:通过任何训练或微调,Gridattn将GFLOPS降低[4.6%,16.1%]和GPU推断潜伏期的范围[8.2%,21.4%],同时达到等效性能(绩效偏见比率低于1%)。此外,提出的实验表明,Gridattn也可以从头开始训练,也可以通过微调的微调成本进行微调,从而大大提高了性能效率 - 折衷方案。作为建议,我们鼓励社区直接部署训练有素的变压器,对预先训练的训练训练,或从头开始训练新的变压器时,将社区合并。源代码将在https://github.com/pengyulpy/gridattn中发布。

网格注意力:提高大型视力模型的计算效率,而无需微调

主要关键词