机构名称:

¥ 1.0

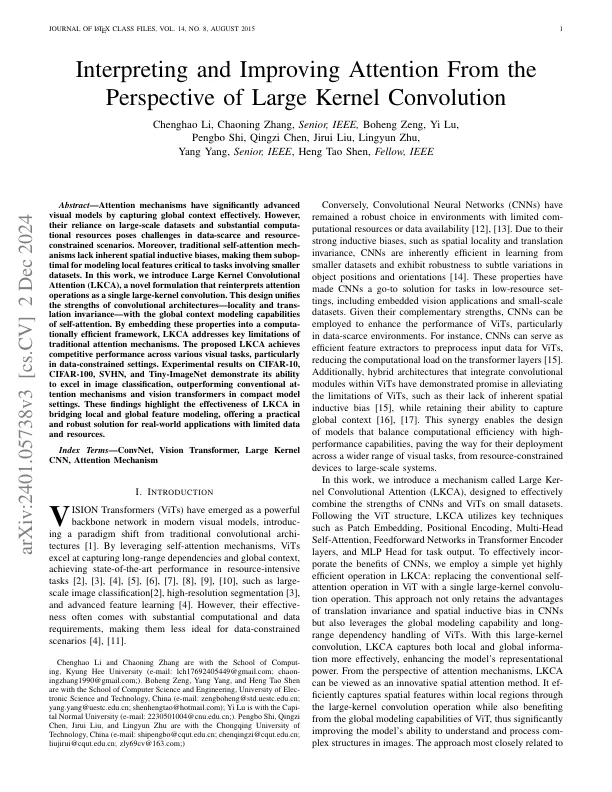

摘要 - 注意机制通过有效捕获全球环境具有显着高级的视觉模型。但是,它们对大规模数据集和实质性计算资源的依赖构成了数据筛查和资源约束方案的挑战。此外,传统的自我发作的机械主义缺乏固有的空间归纳偏见,这使它们成为对涉及较小数据集至关重要的任务至关重要的局部特征进行建模的。在这项工作中,我们引入了大型内核卷积(LKCA),这是一种新型的表述,将注意力重新诠释为单一的大内核卷积。这种设计统一了卷积体系结构的优势 - 本地性和跨性别不变性,具有自我注意力的全球背景建模能力。通过将这些属性嵌入计算高效的框架中,LKCA解决了传统注意机制的关键局限性。所提出的LKCA在各种视觉任务中实现竞争性能,尤其是在数据约束的设置中。对CIFAR-10,CIFAR-100,SVHN和TININE-IMAGENET的实验结果证明了其在图像分类中出色的能力,在紧凑型模型设置中表现出色,表现优于常规的强度机制和视觉变压器。这些发现突出了LKCA在桥接本地和全球功能建模中的有效性,为具有有限的数据和资源的现实世界应用提供了实用且强大的解决方案。

从大内核卷积的角度来解释和提高注意力

主要关键词