机构名称:

¥ 1.0

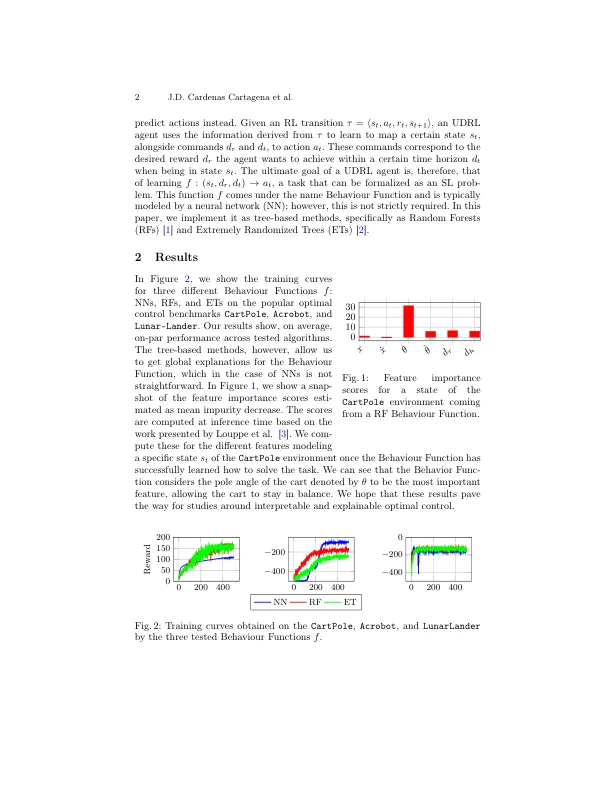

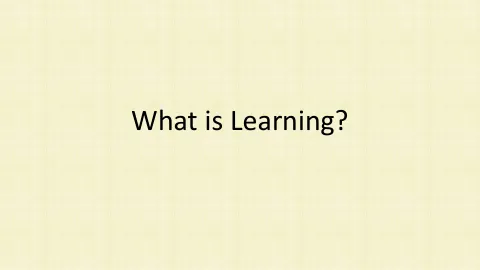

摘要。无模型增强学习(RL)算法要么学习如何将状态映射到预期的奖励,要么搜索可以最大程度地提高某些性能功能的策略。基于模型的算法,旨在学习RL环境的基础模型的近似值,然后将其与计划算法结合使用。倒置强化学习(UDRL)是一种新颖的学习范式,旨在学习如何从国家和所需命令中预测行动。此任务是作为监督学习(SL)问题提出的,并已通过神经网络(NNS)成功解决。在本文中,我们研究了功能近似算法是否也可以在UDRL框架中使用。在几个流行的最佳控制基准上执行的我们的经验表明,基于树木的方法(如随机森林和极端的树木)的性能和NNS的性能一样,具有显着的好处,从而产生了固有的策略,这些政策本质上比NN更容易解释,因此为更多的透明,安全,安全和强大的,强大的,强大的RL铺平了道路。

颠倒 - 提升学习学习 -

主要关键词