机构名称:

¥ 2.0

基于生物奖励的学习中的一个计算问题是如何在Accumbens(NAC)中执行信用分配以更新突触权重。许多研究表明,NAC多巴胺编码时间差异(TD)错误来学习价值预测。但是,多巴胺是在区域均匀浓度中同步分布的,该浓度不支持明确的信用分配(如背波使用)。尚不清楚单独的分布式错误是否足以使突触进行协调更新以学习复杂的,非线性奖励的学习任务。我们设计了一种新的深Q学习算法(一种人工D opamine)来计算证明,同步分布的每层TD误差可能足以学习令人惊讶的复杂RL任务。我们通过经验评估了我们在漫画,深度控制套件和经典控制任务上的算法,并表明它通常可以实现与使用反向流向的深度RL算法相当的性能。

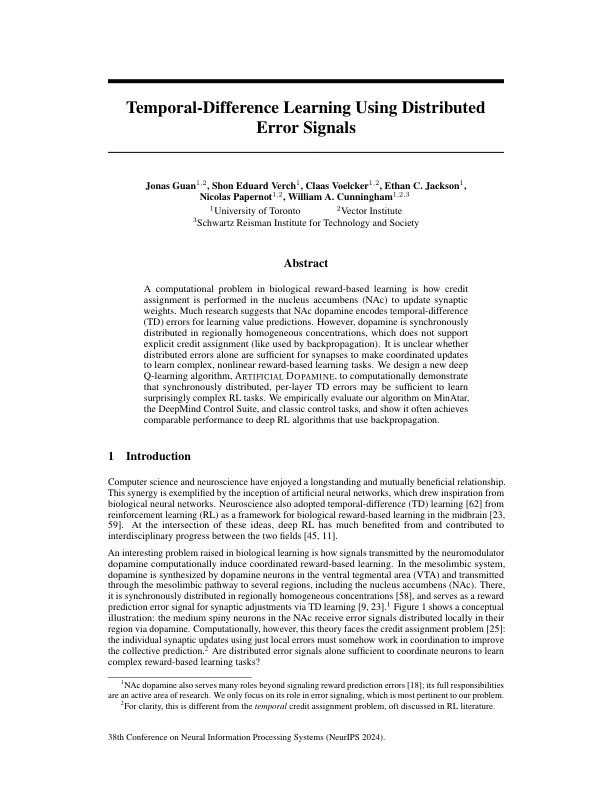

使用分布式错误信号