机构名称:

¥ 1.0

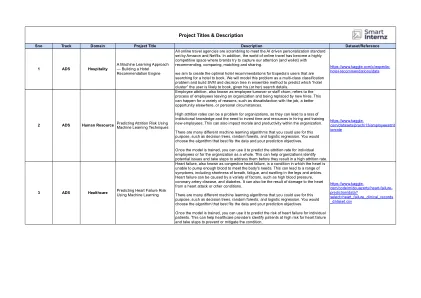

收到:2024年9月22日修订:2024年10月25日接受:2024年11月14日发布:2024年11月30日摘要 - 在生产环境中,机器学习模型经常遇到与培训环境有很大不同的数据和操作条件。这些差异导致各种挑战,例如数据漂移,概念漂移,有害的反馈回路,对抗性攻击,模型故障以及可能在现实世界应用中出现的潜在偏见。模型可解释性在这些环境中也至关重要,因为了解模型如何做出决策对于调试,信任建设和减轻任何可能导致不公平结果的无意偏见是必要的。本文深入探讨了这些挑战,提出了处理它们的有效策略。从行业实践和研究见解中汲取了论文,概述了关键解决方案,例如动态再培训,版本控制,对抗性培训,强大的监视和公平感知到的模型评估,以确保持续的模型绩效和股权绩效和股权后剥夺。

机器学习模型的部署监视