机构名称:

¥ 2.0

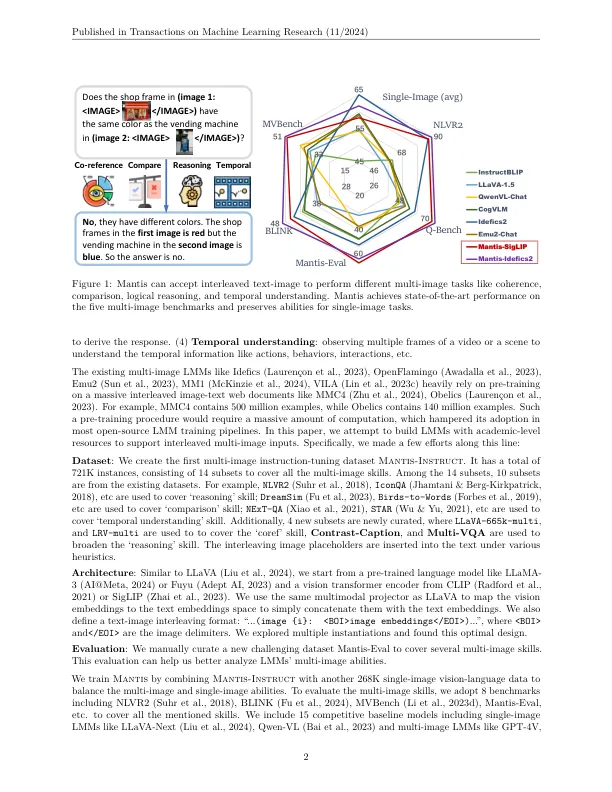

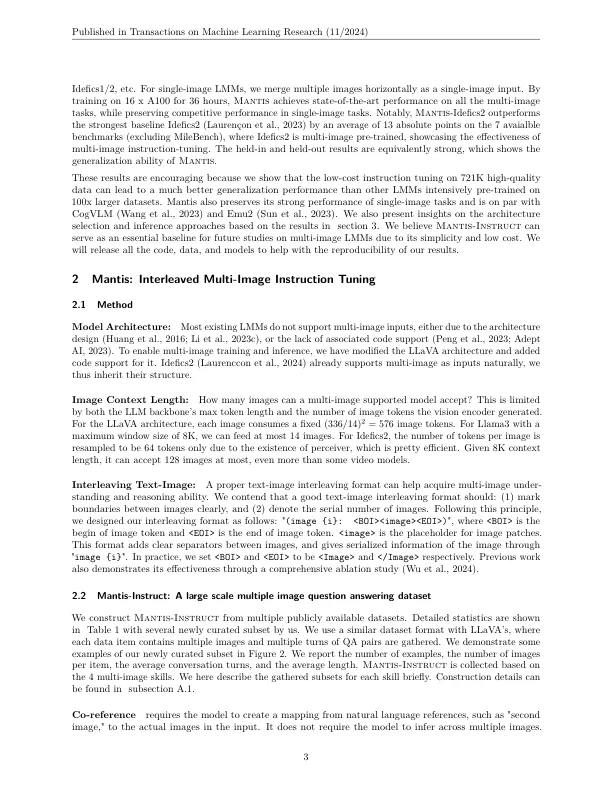

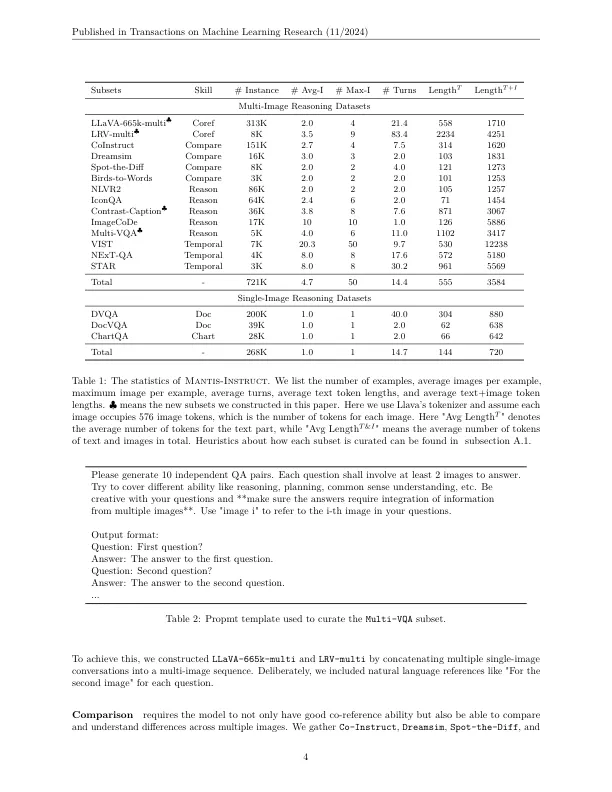

大型多模型模型(LMM)在单图像视觉语言任务中显示出了很好的结果。但是,他们解决多图像视觉语言任务的能力尚待改进。OpenFlamingo,EMU2和IDEFICS等现有的LMM通过对数亿个既没有有效又不有效的嘈杂的交织图像文本数据进行预训练,从而获得了多图像的能力。在本文中,我们旨在通过使用学术级别的资源进行指导调整来构建强大的多图像LMM。因此,我们精心构建包含721k多图像指导数据的螳螂教学,以培训螳螂模型家族。教学调整使螳螂具有不同的多图像技能,例如共同参考,比较,推理和时间理解。我们评估了8个多图像基准和6个单图像基准的螳螂。Mantis -IDEFICS2可以在所有多图像基准上实现SOTA结果,并击败最强的多图像基线,即IDEFICS2-8B平均13个绝对点。值得注意的是,IDEFICS2-8B已在140m的交织多图像数据上进行了预训练,该数据比Mantis-Instruct大200倍。我们观察到螳螂在持有的基准和持有的基准上表现出色,这表明其概括能力。我们进一步评估了单图像基准上的Mantis,并证明Mantis在与COGVLM和EMU2相当的情况下还保持了强劲的单像性能。我们的结果表明,多图像能力不一定是通过大规模的预训练获得的,而是通过低成本的指导调整可以获得它们。螳螂的培训和评估为未来的工作铺平了道路,以提高LMMS的多图像能力。

Mantis:交错的多图像指令调整

主要关键词