机构名称:

¥ 1.0

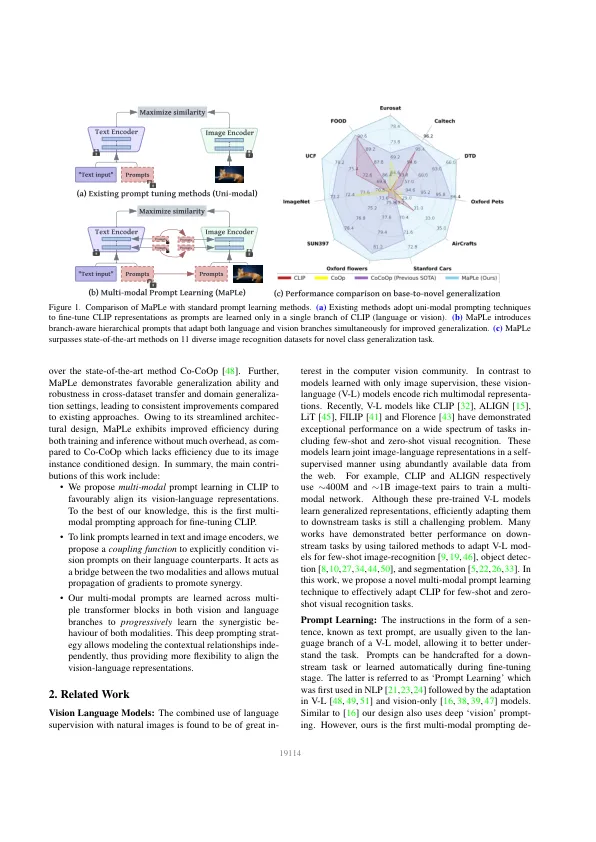

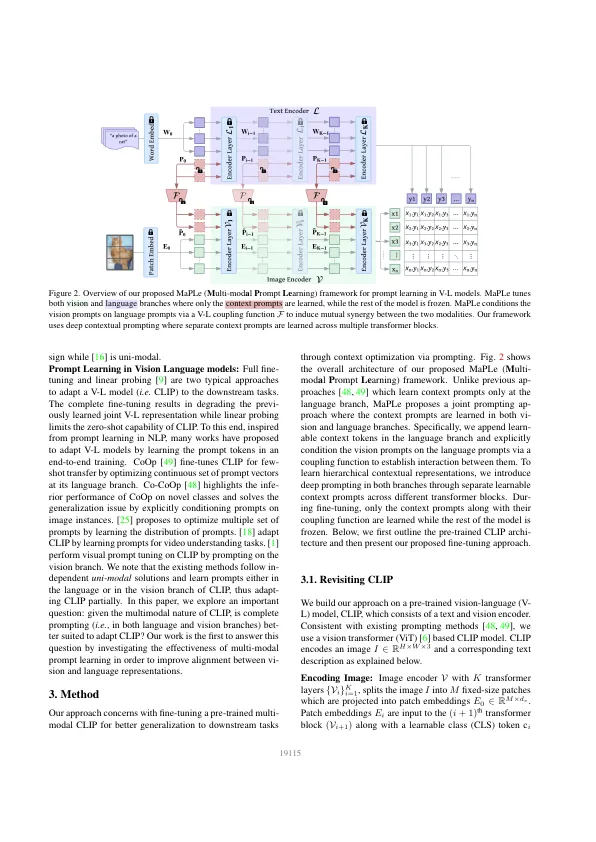

预训练的视觉语言(V-L)模型(例如剪辑)表现出了出色的泛化能力,可以在下游任务下进行。但是,它们对选择输入文本提示很敏感,需要仔细选择及时模板才能表现良好。受到自然语言处理(NLP)文献的启发,最近的剪辑适应方法学习提示是作为下流任务的文本输入的文本输入。我们注意到,在剪辑的单个分支(语言或视觉)中使用提示将代表改编为亚最佳选择,因为它不允许在下游任务上动态调整两个表示空间。在这项工作中,我们提出了视觉和语言分支的多模式提示学习(枫),以证明视觉和语言代表之间的一致性。我们的设计促进了视觉语言提示之间的牢固耦合,以确保相互协同作用并宣扬学习独立的单模式解决方案。,我们在不同的早期阶段学习了单独的提示,以逐步建模阶段的特征关系,以允许丰富的上下文学习。我们评估了方法对新的类别,新的目标数据集和看不见的主要变化的三个代表性任务的有效性。与最先进的方法合作社相比,枫木表现出良好的性能,并且在新型类别上获得了3.45%的绝对增益,而总体谐音均值为2.72%,平均有11种不同的图像识别数据集。我们的代码和预培训模型可在https://github.com/muzairkhattak/multimodal- strick-learning上找到。

枫木:多模式提示学习

主要关键词