机构名称:

¥ 1.0

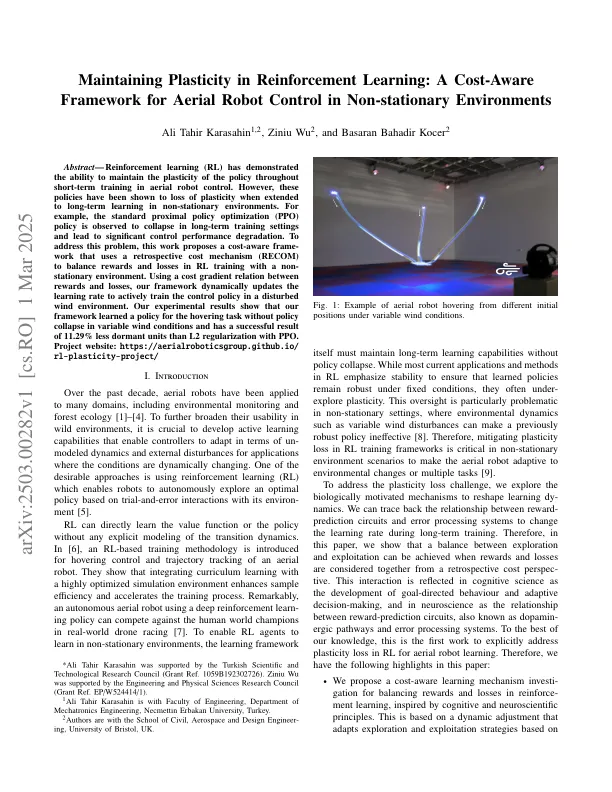

摘要 - 增强学习(RL)已经证明了在空中机器人控制中的短期培训中保持政策可塑性的能力。但是,在非平稳环境中长期学习时,这些策略已显示出可塑性的丧失。例如,观察到标准近端策略优化(PPO)策略在长期培训环境中崩溃并导致重大控制绩效降级。为了解决这个问题,这项工作提出了一项成本吸引力的框架,该工作使用回顾性成本机制(ROCOM)与非固定环境平衡RL培训中的奖励和损失。使用奖励和损失之间的成本梯度关系,我们的框架动态更新了学习率,以在受干扰的风环境中积极训练控制政策。我们的实验结果表明,我们的框架在不同的风条件下学习了悬停任务的政策,而在可变的风条件下,与使用PPO的L2正则化相比,在可变风条件下的政策崩溃,休眠单位的休眠单位少11.29%。项目网站:https://aerialroboticsgroup.github.io/ rl-plasticity-project/

非 - ...