机构名称:

¥ 1.0

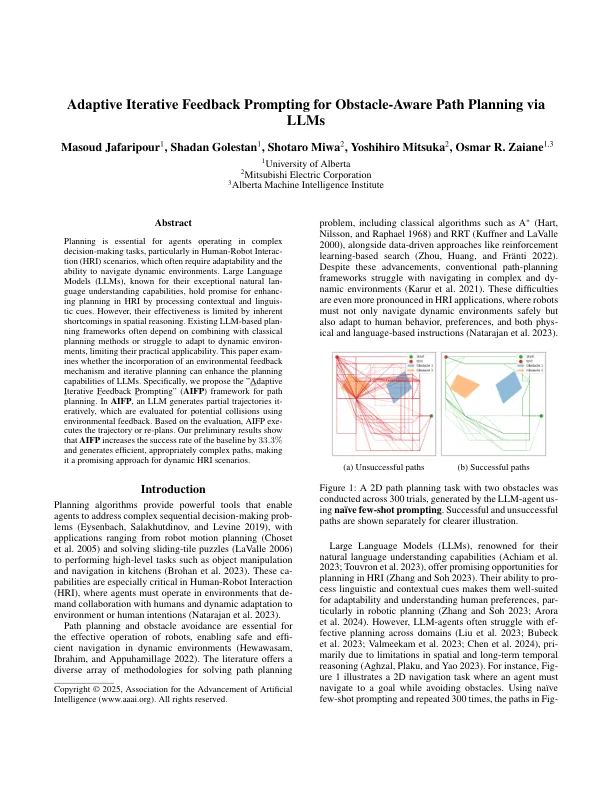

规划对于在复杂的决策任务中运作的代理商至关重要,尤其是在人类机器人互动(HRI)方案中,该方案通常需要适应性和导航动态环境的能力。大型语言模型(LLMS)以其出色的自然语言理解能力而闻名,通过处理上下文和语言提示,可以在HRI中提高HRI的计划。但是,它们的有效性受到空间推理中固有的缺点的限制。现有的基于LLM的计划框架通常取决于与经典计划方法结合或难以适应动态环境,从而限制了它们的实际适用性。本文审查了环境反馈机制和迭代计划是否可以增强LLM的计划能力。具体来说,我们提出了“自适应迭代反馈提示”(AIFP)路径计划框架。在AIFP中,LLM生成了部分轨迹,并通过环境反馈评估了潜在的碰撞。基于评估,AIFP升级了轨迹或重新计划。我们的初步结果表明,AIFP将基线的成功率提高了33。3%,并生成有效的,适当的复杂路径,使其成为动态HRI场景的有希望的方法。

自适应迭代反馈提示通过llms

主要关键词