机构名称:

¥ 1.0

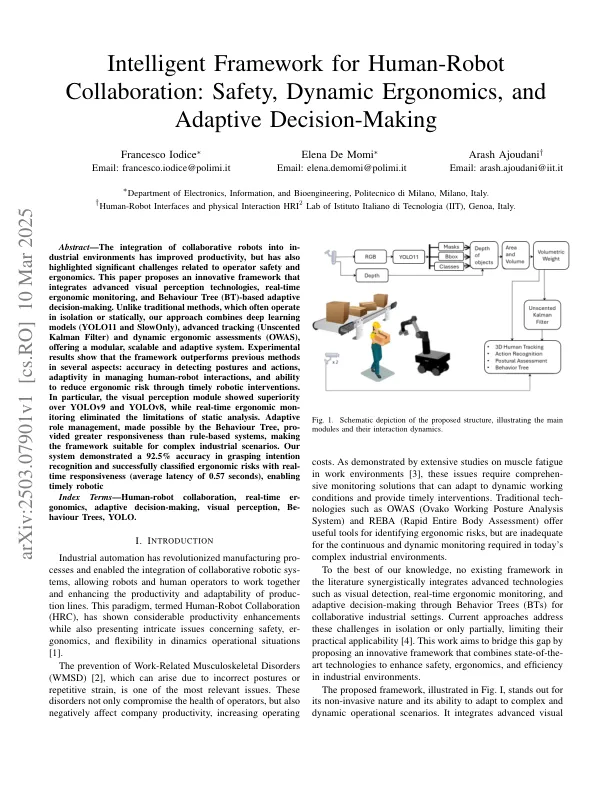

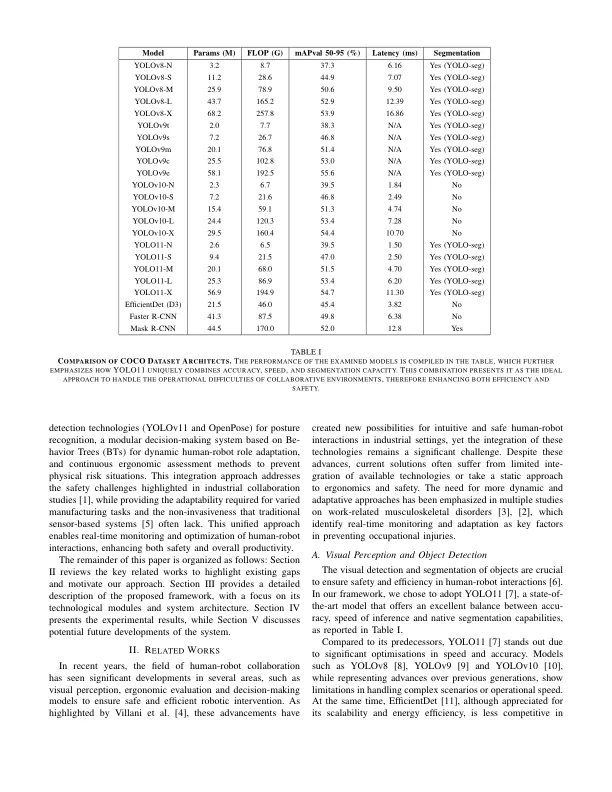

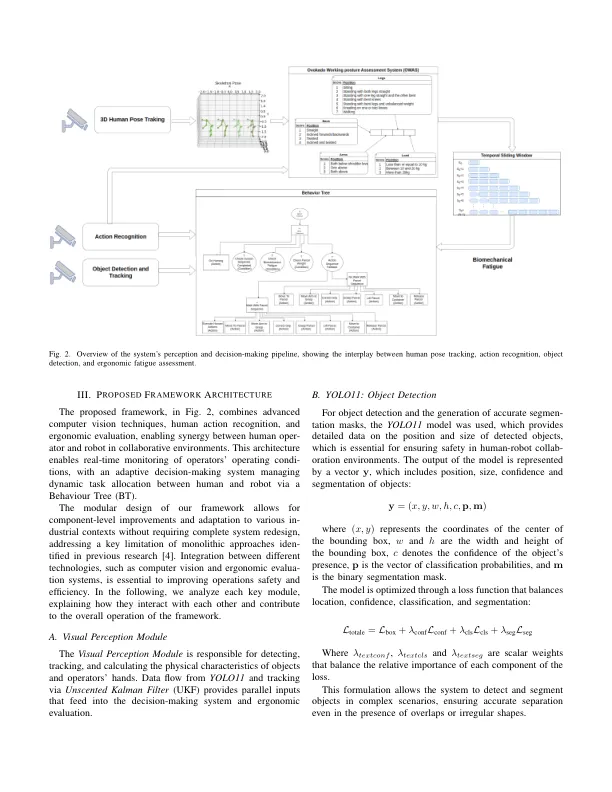

摘要 - 将协作机器人集成到工业环境中的整合提高了生产率,但也强调了与操作员安全和人体工程学相关的重大挑战。本文提出了一个创新的框架,该框架集成了先进的视觉感知技术,实时人体工程学监测和行为树(BT)基于自适应的决策。与通常在孤立或静态上运行的传统方法不同,我们的方法结合了深度学习模型(Yolo11和缓慢地),先进的跟踪(无流感的卡尔曼滤波器)和动态的人体工程学评估(OWAS),提供了模块化,可扩展和适应性系统。实验结果表明,该框架在几个方面都优于先前的方法:检测姿势和动作的准确性,在管理人类机器人相互作用方面的适应性以及通过及时的机器人干预措施降低人体工程学风险的能力。尤其是,视觉感知模块比Yolov9和Yolov8具有优越性,而实时人体工程学的概念消除了静态分析的局限性。自适应角色管理是由行为树实现的,比基于规则的系统具有更大的响应能力,使该框架适合复杂的工业场景。我们的系统在掌握意图识别方面的准确性为92.5%,并成功地将人体工程学风险分类为实时响应能力(平均延迟为0.57秒),使及时的机器人指数术语 - 人类机器人合作,实时的eR-GONOMICS,实时的eR-GONOMICS,适应性的决策,视觉感知,视觉感知,是Haviour haviour tree Yolo,Yolo。

安全,动态人体工程学和自适应决策

主要关键词