机构名称:

¥ 1.0

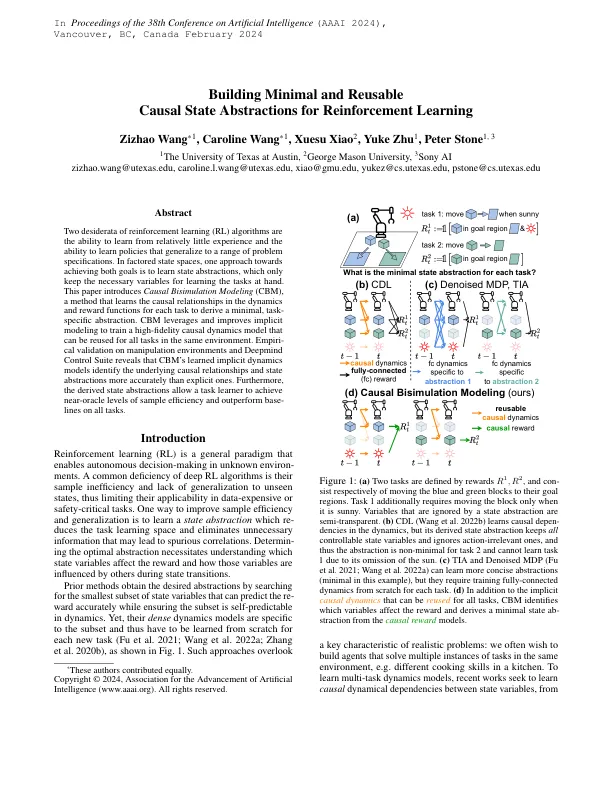

两种强化学习(RL)算法的Desiderata是从相对较少的经验学习和学习概括到一系列问题规格的政策的能力的能力。在有方面的状态空间中,实现这两个目标的一种方法是学习状态抽象,这仅保留学习手头的任务的必要变量。本文介绍了因果分配模型(CBM),该方法可以了解每个任务的动力学和奖励功能中的因果关系,以得出最小,特定于任务的抽象。CBM利用并改进了隐式建模,以训练可以在同一环境中所有任务重复使用的高保真因果动力学模型。对操纵环境和DeepMind Control Suite的经验验证表明,CBM学到的隐式动力学模型比显式的因果关系模型更准确地识别了基本的因果关系和状态抽象。此外,派生的状态抽象允许任务学习者在所有任务上实现近门槛级别的样本效率和表现优于基础线。

建立最少和可重复使用的因果状态抽象来加强学习