机构名称:

¥ 1.0

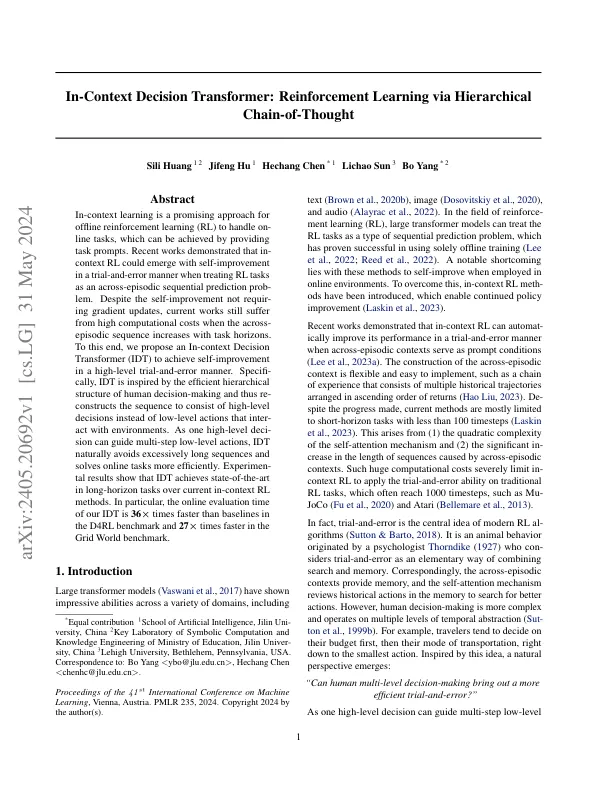

抽象的内在学习是离线加固学习(RL)来处理内线任务的一种有前途的方法,可以通过提供任务提示来实现。最近的著作表明,当将RL任务视为跨散点的顺序预测概率时,In-Actest RL可能会以反复试验的方式进行自我完善。尽管自我改善不需要梯度更新,但是当跨情节序列随着任务范围而增加时,当前的作品仍处于高计算成本。为此,我们提出了一个内在的决策变压器(IDT),以高级反复试验的方式实现自我完善。特定于IDT的灵感来自人类决策的有效层次结构,因此将序列重新构造为由高级决策组成,而不是与环境相互作用的低级动作。作为一个高级决策可以指导多步骤的低级动作,IDT自然会避免过度长序列并更有效地解决在线任务。实验结果表明,IDT超过了当前的内在RL方法,可以实现长胜压任务的最新任务。尤其是,我们的IDT的在线评估时间比D4RL基准中的基线快36倍,而在网格世界基准中,我们的IDT时间比基准的速度快27倍。

通过层次结构链进行加强学习

主要关键词