机构名称:

¥ 3.0

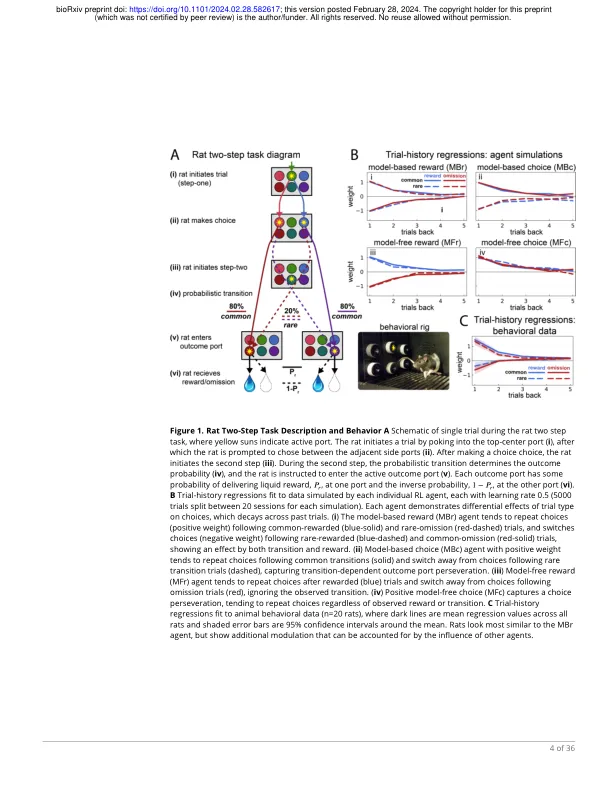

已经假设抽象的不同大脑系统来处理8个竞争以产生行为的“专家”。在增强学习中,两个通用过程,一个无模型的9(MF)和一个基于模型的(MB),通常被建模为代理(MOA)的混合物(MOA)和10个假设,以捕获自动性与审议之间的差异。但是,静态MOA无法捕获11个策略的变化。为了研究这种动态,我们提出了12个代理的隐藏马尔可夫模型(MOA-hmm),同时从一组代理中学习了13个动作值,以及基本“隐藏”的时间动态,即随着时间的推移,代理贡献中14个捕获转移。将此模型应用于大鼠的多步,15个奖励指导的任务,揭示了会议内策略的进展:从最初的16 MB探索到MB剥削,并最终降低了参与度。被推论的状态17预测任务过程中响应时间和OFC神经编码的变化,这表明18个状态正在捕获动力学的实际转移。19

动态强化学习揭示了奖励学习过程中战略的时间依赖性转变

主要关键词