机构名称:

¥ 1.0

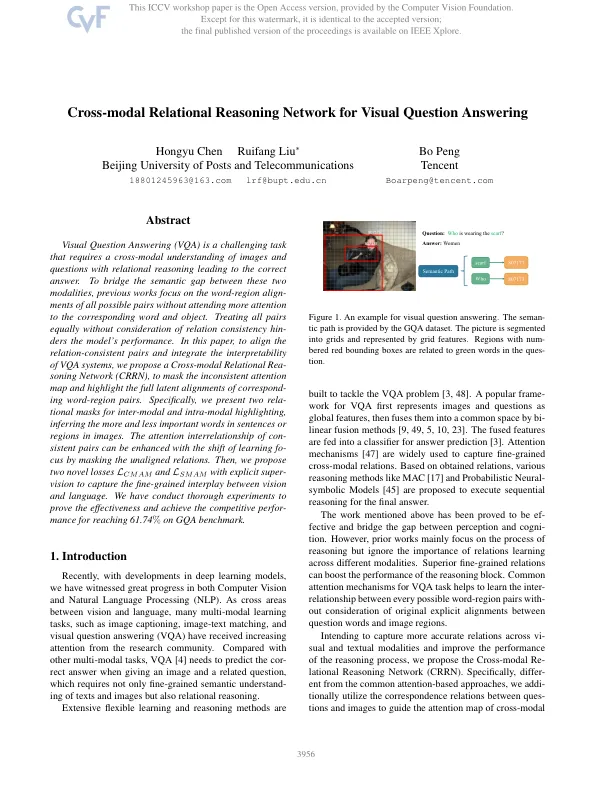

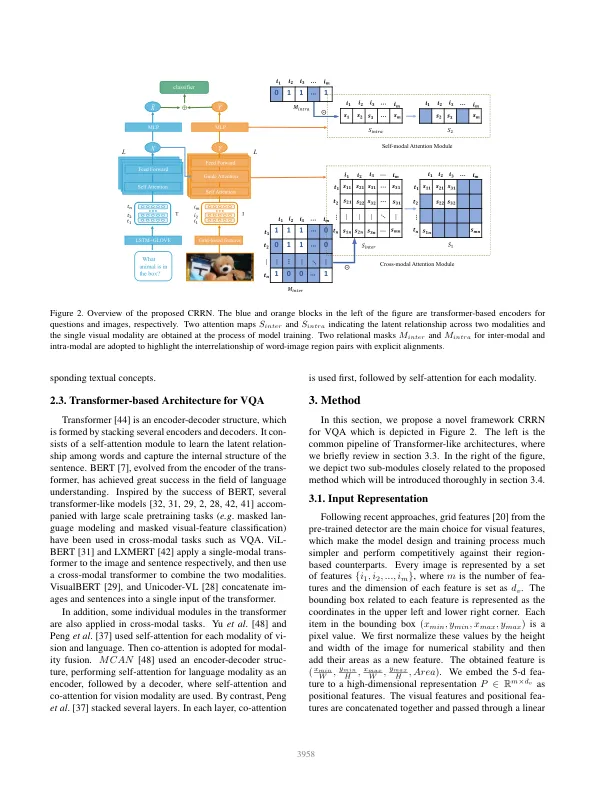

视觉问题回答(VQA)是一项具有挑战性的任务,需要通过关系推理对图像和问题进行跨模式理解,从而导致正确答案。为了弥合这两种方式之间的语义差距,以前的作品着重于所有可能对的单词区域对齐,而无需更多地关注相应的单词和对象。同样处理所有对,而无需考虑关系一致性,这是模型的性能。在本文中,为了对齐关系对并整合VQA系统的解释性,我们提出了一个跨模式的关系构建网络(CRRN),以掩盖不一致的注意力图,并突出相应单词对的全部潜在比对。具体来说,我们提出了两个相关性掩码,用于模式间和模式内突出显示,从而推断出图像中句子或区域中越重要的单词。可以通过掩盖未对齐的关系来增强一致对的关注相互关系。然后,我们提出了两个新颖的损失L CMAM和L SMAM,并具有明确的超级视觉,以捕获视觉和语言之间的细粒度相互作用。我们进行了彻底的实验来证明有效性并实现了GQA基准的竞争性绩效,以达到61.74%。

视觉问题的跨模式关系推理网络回答

主要关键词